« VISI201 CMI : visite de laboratoire » : différence entre les versions

Aucun résumé des modifications |

|||

| (297 versions intermédiaires par 31 utilisateurs non affichées) | |||

| Ligne 1 : | Ligne 1 : | ||

* Cours du semestre 2 du parcours CMI Informatique (licence INFO). |

|||

* Responsable pour 2024--2025: Pierre Hyvernat |

|||

[[VISI201 Analyse syntaxique (Tristan Porteries, 2018)]] |

|||

* Responsable 2016--2024 : Jacques-Olivier Lachaud |

|||

= Descriptif = |

|||

Un algorithme d'analyse syntaxique est un algorithme permettant de reconnaître l'existence d'un mot selon un langage, en cas général il est appliqué pour les langages informatiques et valide ou non un code source pour la syntaxe d'un langage informatique dans tous les compilateurs et interpréteurs. Mais la plupart des analyseurs syntaxiques ne se contentent pas seulement de valider l'entrée, ils extraient aussi la construction de cette entrée sous la forme d'un arbre abstrait de syntaxe détenant le sens de la chaîne d'entrée. |

|||

L'objectif du module est de faire découvrir les laboratoires, le monde de la recherche et les enseignants-chercheurs et chercheurs, ainsi que la réflexion scientifique. Cela se fait de deux manières. |

|||

== Les grammaires == |

|||

D'abord, une partie de ce module consiste à assister à des séminaires dédiés aux étudiants CMI Informatique et Mathématique (environ 5 par an). [[https://www.lama.univ-savoie.fr/pagesmembres/lachaud/CMI_html/news Planning séminaires CMI]] |

|||

=== Les symboles de grammaire === |

|||

Ces séminaires "grand public" portent sur des sujets variées en informatique et mathématiques. |

|||

Toutes les grammaires sont composées de symboles regroupés sous deux catégories, les terminaux et le non-terminaux. |

|||

Les étudiants choisissent ensuite d'approfondir un sujet proposé par les enseignants, ou un sujet motivé de leur choix (en accord avec le responsable du module). Ce travail se fait en interaction avec un tuteur académique (5-6 contacts au moins). Ce travail personnel tuteuré donne lieu à la rédaction d'une synthèse sur le sujet sous forme d'une page wiki/web, ainsi que d'un mini-exposé, et du code si le sujet s'y prête. |

|||

Les terminaux sont les symboles les plus petits ne pouvant être subdivisé, ils forment la chaîne d'entrée. |

|||

== Sujets proposés (2025-2026) == |

|||

Les non-terminaux sont des symboles pouvant être subdivisé, il servent à regrouper d'autre symboles. Il sont toujours associés à des productions décrivant les subdivisions possible. |

|||

=== [[le bytecode Python]] === |

|||

''' Tuteur :''' Pierre Hyvernat |

|||

Par exemple une grammaire pourrait définir le non-terminal <math>float</math> qui englobe toutes les expressions de littéraux de flottants, ce non-terminal se subdiviserait selon <math>float \rightarrow nombre\ .\ nombre</math>, ainsi toutes les chaînes d'entrées composées d'un nombre puis un point et un nombre pouront être englobées par le non-terminal <math>float</math>. |

|||

''' Résumé :''' Python est un langage "interprété". Un programme Python n'est jamais directement transformé en suite d'instructions pour le processeur sur lequel il doit s'exécuter. C'est l'interpréteur qui va, lors de l'exécution, regarder les instructions Python pour les exécuter. Pour éviter que le passage par cet intermédiaire prenne trop de temps, le programme Python est d'abord transformé en un "langage intermédiaire" appelé "bytecode". Ce langage est une espèce de langage d'assemblage propre à Python. Les instructions sont beaucoup plus simples à exécuter que les instructions "haut niveau" et sont identiques pour tous les processeurs. |

|||

<ul> |

|||

<li>4.2</li> |

|||

<li><math>nombre\ .\ nombre</math></li> |

|||

<li><math>float</math></li> |

|||

</ul> |

|||

L'outils principal pour étudier le bytecode python est le module <tt>dis</tt> (comme <tt>dis</tt>assembler) de la version usuelle de Python (CPython). |

|||

=== Les productions de grammaires === |

|||

'''Objectifs :''' |

|||

Les productions décrivent les subdivisions de non-terminaux, dans le cas d'une grammaire non-contextuelle toutes les productions sont de la forme : |

|||

* comprendre la différence entre les langages compilé et interprétés |

|||

* comprendre globalement le mécanisme de transformation d'un programme Python en bytecode |

|||

* étudier le bytecode produit sur des exemples particuliers et pertinents (<tt>if</tt>, <tt>for</tt>, comprehension sur les listes, etc.) |

|||

* comprendre la différence entre les fonctions "builtin" et les définitions Python. |

|||

'''Références :''' |

|||

<math>A \rightarrow \gamma </math> |

|||

* une description d'un programme pour interpréter du bytecode Python : [https://aosabook.org/en/500L/a-python-interpreter-written-in-python.html A Python Interpreter Written in Python] |

|||

* un livre gratuit sur la machine virtuelle Python : [https://leanpub.com/insidethepythonvirtualmachine Inside The Python Virtual Machine] |

|||

* une vidéo (que je n'ai pas encore visionnée) sur le bytecode : Python https://www.youtube.com/watch?v=cSSpnq362Bk |

|||

=== [[Algorithme de Viterbi et modèles de Markov cachés]] === |

|||

<ul> |

|||

<li><math>A</math> : un non-terminal.</li> |

|||

<li><math>\gamma</math> : une composition de terminaux et non-terminaux.</li> |

|||

</ul> |

|||

'''Tuteur :''' Sébastien Tavenas |

|||

Un non-terminal peut être dérivé par une des ses productions associées, il est alors réécrit par la partie droite d'une production. Cette opération mène à une proto-phrase, cette proto-phrase est une phrase si elle est constituée seulement de terminaux. |

|||

De même il est possible de réduire une proto-phrase en un non-terminal par une des productions ayant en partie droite la proto-phrase. |

|||

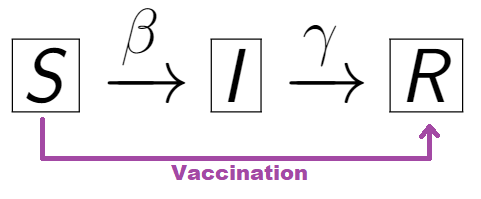

'''Résumé :'''

de nombreux phénomènes du monde réel évoluent dans le temps et peuvent être modélisés comme des suites d’états successifs : reconnaissance de la parole, analyse de séquences biologiques, |

|||

=== La hiérachie de Chomsky === |

|||

correction automatique de texte, etc. Dans ces situations, l’état réel |

|||

du système n’est pas toujours directement observable.

Les modèles de |

|||

Markov cachés (Hidden Markov Models, HMM) constituent un cadre |

|||

probabiliste simple pour modéliser ce type de processus. |

|||

L’algorithme de Viterbi est un algorithme fondamental permettant de |

|||

La hiérachie de Chomsky définit quatre classes de grammaires, chacune pouvant décrire toutes les règles des grammaires de hiérarchie inférieur, les grammaires générales couvrent toutes les grammaires possibles. |

|||

déterminer la suite d’états cachés la plus probable ayant généré une |

|||

séquence d’observations.

Ce projet propose d’étudier cet algorithme, |

|||

d’en comprendre le principe puis de l’implémenter et de l’appliquer sur |

|||

des exemples. |

|||

'''Objectifs :

''' |

|||

[[Fichier:Chomsky.png|300px]] |

|||

# Comprendre les chaînes de Markov et les modèles de Markov cachés

|

|||

# Comprendre le principe de l’algorithme de Viterbi et son lien avec la programmation dynamique

|

|||

# Implémenter l’algorithme de Viterbi |

|||

* Pistes d’applications possibles :

|

|||

Le niveau le plus faible est attribué aux grammaires régulières. |

|||

# Deviner une suite d’états météo à partir d’observations bruitées

|

|||

# Décoder une séquence de lettres bruitées

# Peut-être, décodage d’un code de convolution |

|||

'''Références :'''

|

|||

<ul> |

|||

# Algorithme de Viterbi (Wikipedia) : https://fr.wikipedia.org/wiki/Algorithme_de_Viterbi

|

|||

<li>Les grammaires régulières sont d'une forme linéaire gauche ou droite, chaque non-terminal peut être associé à une composition de terminaux et un non-terminal en préfixe ou suffixe seulement. |

|||

# Modèles de Markov cachés : https://fr.wikipedia.org/wiki/Mod%C3%A8le_de_Markov_cach%C3%A9

|

|||

<math>N \rightarrow A\gamma</math> <math>N \rightarrow \gamma A</math> |

|||

# Un exemple pour comprendre : https://www.cis.upenn.edu/~cis2620/notes/Example-Viterbi-DNA.pdf |

|||

</li> |

|||

<li>Les grammaires algébrique (ou non-contextuelles) offrent une plus grande liberté en autorisant d'associer à un non-terminal n'importe quelle combinaison de terminaux et non-terminaux. |

|||

<math>N \rightarrow \gamma</math> |

|||

</li> |

|||

<li>Les grammaires contextuelles sont semblables aux grammaires algébrique mise à part l'ajout d'un contexte autour des productions en partie gauche et partie droite. |

|||

<math>\alpha N\beta \rightarrow \alpha \gamma \beta</math> |

|||

</li> |

|||

<li>Les grammaires régulières rendent possible l'association de n'importe quelle composition de non-terminaux et terminaux vers une autre composition. |

|||

<math>\gamma \rightarrow \phi</math> |

|||

</li> |

|||

</ul> |

|||

=== Les grammaire non-contextuelles === |

|||

=== [[Moteur d’échecs expérimental]] === |

|||

Les grammaires non-contextuelles sont définits de la forme <math>G = (V, A, S, P)</math>. |

|||

'''Tuteur :''' Romain Negro |

|||

<ul> |

|||

<li><math>V</math> : l'ensemble des non-terminaux de la grammaires.</li> |

|||

<li><math>A</math> : l'ensemble des terminaux.</li> |

|||

<li><math>S</math> : le non-terminal axiome.</li> |

|||

<li><math>P</math> : l'ensemble des productions associant un non-terminal à une composition de non-terminaux et terminaux : <math> N \rightarrow \alpha </math>.</li> |

|||

</ul> |

|||

'''Résumé :''' Les échecs sont un jeu qui occupent une place centrale dans l’histoire de l’informatique et de l’intelligence artificielle. Ils ont servi entre-autre de terrain d’expérimentation pour étudier la prise de décision par ordinateur. Un moteur d’échecs est un programme capable de choisir un coup à partir d’une position donnée, selon une stratégie plus ou moins élaborée. |

|||

Dans un contexte plus technique il suffit de préciser l'axiome et les productions car ces dernières listent tout les non-terminaux et terminaux existant. |

|||

L'axiome joue un rôle important dans la validation d'un mot par une grammaire, si des dérivations successives partant de l'axiome mènent à une phrase correspondant au mot d'entrée alors l'entrée est validé. De même si la phrase correspondante au mot d'entrée et réduite jusqu'à obtenir l'axiome. |

|||

Ce projet ne vise pas à reproduire un moteur moderne, mais à imaginer et de développer un moteur simple en s’appuyant sur des idées personnelles : règles heuristiques, évaluations simples, choix aléatoires contrôlés, ou toute autre approche qui vous semble pertinente. Le moteur devra ensuite se lier via des outils existants grâce au protocole standard UCI (Universal Chess Interface), afin de pouvoir le tester automatiquement. |

|||

Plus formellement, soit <math>\omega</math> le mot d'entrée : <math>S \xrightarrow{*} \omega</math>. |

|||

Enfin, différentes méthodes d’évaluation seront explorées pour tester le moteur : comparaison par parties automatisées, estimation d’un score Elo, et résolution de positions tests (puzzles). |

|||

== Les analyseurs lexicaux == |

|||

L'analyse lexicale couvre toutes les règles de la grammaire régulière, elle est utilisée pour faciliter le travail de l'analyseur syntaxique par la reconnaissance de certain groupe de lexème (les noms de variables, les nombres entiers, les nombres flottants) en unité lexicale. Ces unités lexicales seront utilisées comme terminaux par l'analyseur syntaxique et formeront donc la chaine d'entrée. |

|||

'''Objectifs :''' |

|||

La plupart des règles d'une grammaire régulière sont décrites avec des expressions rationnelles se basant sur trois opérations fondamentales : la concaténation, l'union et l'étoile de Kleene. Chacune de ces opérations produit un ensemble de mot pouvant être reconnu par le motif. |

|||

#Imaginer et développer un moteur d’échecs simple basé sur une stratégie personnelle, dans le langage de son choix (python recommandé) |

|||

<ul> |

|||

#Rendre compatible ce moteur avec le protocole standard UCI, |

|||

<li>La concaténation permet de créer un singleton avec la concaténation de deux mots, autrement dit reconnaître que la concaténation de deux mots. <math>ab \rightarrow \{ab\}</math></li> |

|||

#Comparer et évaluer le moteur à l’aide de parties automatisées, d’un calcul d'un score Elo approximatif et de séries de puzzles. |

|||

<li>L'union crée un ensemble constituée des deux mots, elle reconnaît l'un de deux mots seulement. <math>a|b \rightarrow \{a, b\}</math> </li> |

|||

<li>L'étoile de Kleene permet de créer un ensemble contenant toutes les combinaisons d'un ensemble ainsi que le vide. <math>(a|b)^* \rightarrow \{\epsilon, a, b, ab, ba, aab, ...\}</math> </li> |

|||

</ul> |

|||

L'analyseur lexicale sépare en premier la chaine selon les blancs et d'autres séparateurs supplémentaires tels que les signes de ponctuations et les opérateurs, ensuite chaque portion de la chaine d'entrée est analysée selon un ensemble de règles rationnelles pour déterminer son unité lexicale. |

|||

'''Références :''' |

|||

Par exemple la chaine d'entrée "float i = 4.2 + 5;" sera découpée en {"float", "i", "=", "4.2", "+", "5", ";"}, ensuite selon les règles suivantes (utilisant le format de regex POSIX) : |

|||

#[https://www.chessprogramming.org/UCI UCI – Universal Chess Interface] |

|||

<ul> |

|||

#[https://fr.wikipedia.org/wiki/Classement_Elo Classement Elo] |

|||

<li> type <math> \rightarrow </math> (int|float|bool) </li> |

|||

#[https://www.chessprogramming.org/Main_Page Chess Programming Wiki] |

|||

<li> id <math> \rightarrow </math> ([A-z]([A-z]|[0-9])*)[^(int|float|bool)] </li> |

|||

#[https://www.chess.com/article/view/history-of-computer-chess Histoire des ordinateurs d’échecs] |

|||

<li> op_assign <math> \rightarrow </math> = </li> |

|||

<li> float <math> \rightarrow </math> [0-9]*\.[0-9]*f? </li> |

|||

<li> int <math> \rightarrow </math> [0-9]* </li> |

|||

<li> end <math> \rightarrow </math> ; </li> |

|||

<li> op <math> \rightarrow </math> \+|\-|/|\* </li> |

|||

</ul> |

|||

=== [[Algorithmes de multiplications d'entiers et de matrices]] === |

|||

On obtiendra donc un ensemble des unités lexicales reconnues : {type, id, op_assign, float, op, int, end}. |

|||

'''Tuteur :''' Valentin Gledel |

|||

=== Les automates finis === |

|||

'''Résumé :''' Les algorithmes de multiplication classiques, utilisés pour calculer des multiplications d'entiers ou de matrices à la main avec un papier et un crayon, sont assez peu efficaces lorsqu'il s'agit d'effectuer de très grandes multiplications et des algorithmes dédiés existent pour faire ces opérations bien plus rapidement, en utilisant des algorithmes "diviser pour régner" ou la transformée de Fourier rapide. |

|||

Un analyseur lexicale peut être construit avec un automate finis car d'après le théorème de Kleene toutes les grammaires régulière sont reconnu par un automate finis. |

|||

Théorème de Kleene : l’ensemble des langages rationnels sur un alphabet A est exactement l’ensemble des langages sur A reconnaissables par automate fini. |

|||

'''Objectifs :''' |

|||

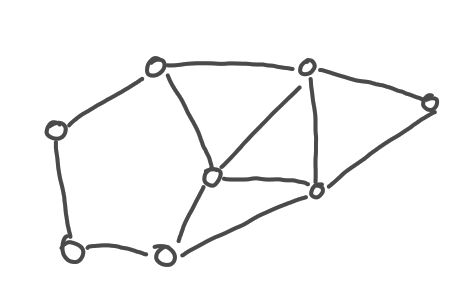

L'automate suivant reconnaît le motif <math>a^*b^*</math> |

|||

* dans un premier temps, implémenter une représentation de grands entiers et des algorithmes de multiplications naïfs pour la multiplication d'entiers et de matrices |

|||

* implémenter l'algorithme de Karastuba pour la multiplication d'entiers et l'algorithme de Strassen pour la multiplication de matrices |

|||

* implémenter l'algorithme de Toom-Cook, une amélioration de l'algorithme de Karastuba |

|||

* implémenter l'algorithme de Freivalds qui permet de vérifier rapidement que le produit de deux matrices A et B est la matrice C. |

|||

* implémenter l’algorithme de Schönhage–Strassen qui utilise la transformée de Fourier rapide pour faire le produit d'entiers |

|||

* comparer tous ces algorithmes et comprendre la notion de complexité d'algorithme |

|||

[[Fichier:Automate-ab.png|400px]] |

|||

'''Référence :''' |

|||

Malheureusement la limite des analyseurs lexicaux et très vite atteint notamment avec le motifs de la forme <math>a^nb^n</math>. Dans ce cas il faut trouver un moyen de compter le nombre de a consommé pour essayer de consommer le même nombre de b, or les automates finis ne dispose pas de mémoire supplémentaire où placer ce compteur. Ce type de motif est fortement utilisé dans les languages de programmations pour vérifier le bon nombre de parenthèses, accolades etc… |

|||

* [https://fr.wikipedia.org/wiki/Algorithme_de_multiplication_d%27entiers Article Wikipédia sur la multiplication d'entiers] |

|||

* [https://fr.wikipedia.org/wiki/Complexit%C3%A9_de_la_multiplication_de_matrices Article Wikipédia sur la multiplication de matrices] |

|||

=== [[Classification de textes grâce à la compression]] === |

|||

== Les analyseurs syntaxiques == |

|||

'''Tuteur :''' Pierre Hyvernat |

|||

L'analyse syntaxique suit l'analyse lexical en se basant sur les unités lexicales définit par ce dernier nommé lexèmes. Ces unités lexicales sont utilisées en tant que terminaux par l'analyseur syntaxique dans une liste de lexèmes. |

|||

'''Résumé :''' les IA modernes sont devenues très bonne pour *classifier* des textes : étant donné un texte (en français par exemple), il s'agit de le relier à une catégorie dans un ensemble donné. Autan il est facile de distinguer une recette de cuisine d'un pièce de théatre, la classification peut devenir plus complexe si l'on souhaite distinguer des textes très courts, ou distinguer des niveaux de langage. |

|||

Les algorithmes d'analyseur syntaxiques se basent tous sur le même type d'automates : les automates finis à pile. Les deux majeurs techniques connus sont l'analyse descendante et l'analyse ascendante. La première consiste à dériver l'axiome de la grammaire jusqu'à obtenir le mot d'entrée, la seconde technique consiste à réduire le mot d'entrée jusqu'à obtenir l'axiome. |

|||

Les techniques habituelles reposent sur des réseaux de neurones profonds, mais des chercheurs ont récemment obtenu des résultats pouvant rivaliser avec ces techniques complexes et gourmandent en calcul en utilisant ... des algorithmes de compression ! |

|||

Ces deux techniques sont considéré comme opposé par leur façon de traiter les proto-phrases, l'analyseur descendant va toujours dériver et l'analyseur ascendant toujours réduire. Malgré cette symétrie, ces deux types d'analyseur n'utilisent pas les mêmes ensembles de règles. |

|||

=== Les automates finis à pile === |

|||

'''Objectifs :''' |

|||

Les automates finis à pile forment une extension des automates finis par l'adjonction d'une mémoire organisée en pile. |

|||

* comprendre la problématique de classification de texte |

|||

* essayer de re-obtenir les résultats décrits dans l'article en codant, en Python un petit programme de classification |

|||

* comparer les résultats obtenus avec différent algorithmes de compression |

|||

* [objectif secondaire] essayer de comparer les résultats obtenus avec des outils modernes plus classiques. |

|||

Ils permettent de couvrir les limitations des analyseurs lexicaux en reconnaissant les motifs de la forme <math>a^nb^n</math>. |

|||

'''Référence :''' |

|||

[[Fichier:Automate-pile-ab.jpg|400px]] |

|||

* [https://arxiv.org/abs/2212.09410 Less is More: Parameter-Free Text Classification with Gzip] |

|||

=== [[Filage d'image et tracé de droites pour un rendu artistique]] === |

|||

Ce type d'automate est utilisé pour les analyseurs syntaxique tant descendant que ascendant. |

|||

'''Tuteur :''' Jacques-Olivier Lachaud |

|||

=== Les analyseurs descendants === |

|||

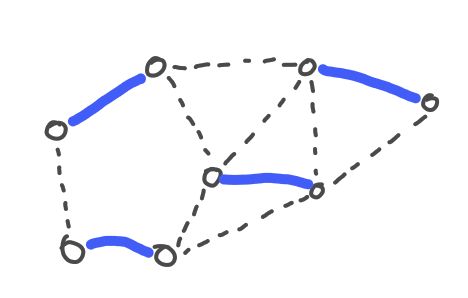

'''Résumé :''' Peut-être avez-vous déjà fait des créations artistiques en enfilant un long fil autour de clous placés sur une planche, en essayant de donner l'illusion d'une forme ou d'une scène ? Nous allons nous intéresser au problème d'approcher au mieux une image (en niveaux de gris) en passant un "fil" noir autour de "clous" disposés autour d'une image blanche. Le fil noir partira d'un clou et on devra décider à chaque étape le prochain clou où passer le fil et ainsi de suite. Au fur et à mesure, si on prend de bonnes décisions, on arrive à dessiner à peu près l'image originale, avec un rendu artistique intéressant. Ce faisant, vous aurez appris à tracer des droites de pixels dans des images et codé un algorithme d'optimisation glouton. |

|||

Le principe de l'analyse descendante est assez simple à mettre en œuvre. L'analyseur initialise une proto-phrase contenant l'axiome de la grammaire, à chaque étape l'analyseur va lire le symbole à gauche de la proto-phrase. Si celui ci est un terminal alors on le compare avec le début de la chaîne d'entrée, si il correspond on consomme le début de la chaine d'entrée ainsi que le terminal au début de la proto-phrase, au contraire on signale une erreur. Si le début de la proto-phrase est un non-terminal alors on le remplace par la partie droite de l'une de ses productions. |

|||

'''Objectifs :''' |

|||

Le pseudo code correspondant est le suivant : |

|||

* Comprendre le principe du filage d'image et du tracé de droites discrètes |

|||

* Coder l'algorithme pour des ensembles quelconques de clous (on commencera par disposer les clous sur les bords de l'image). Il faudra comprendre comment on mesure une erreur de tracé pour une ligne donnée. |

|||

* Tester des variantes: 2 fils (1 blanc, 1 noir sur fond gris), rajouter des clous à l'intérieur du cadre. |

|||

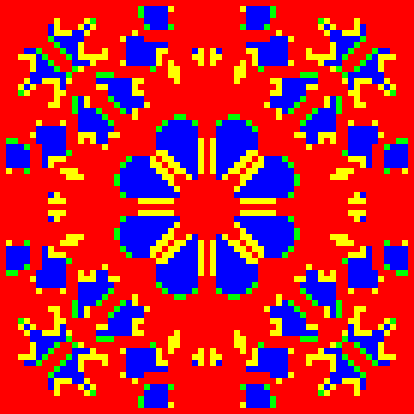

[[Fichier:Filage.png|400px]] |

|||

<pre> |

|||

initialiser une pile contenant S |

|||

Tant que la pile et la chaine d'entrée sont non-vide |

|||

soit C le premier lexème de la chaine d'entrée |

|||

soit T le sommet de la pile |

|||

Si T est non-terminal |

|||

choisir une production P de T |

|||

dépiler le sommet de la pile |

|||

empiler la partie droite de P |

|||

Sinon si T équivaut C |

|||

dépiler le sommet de la pile |

|||

consommer le lexème C |

|||

Sinon |

|||

erreur |

|||

</pre> |

|||

= Archive des sujets réalisés = |

|||

Si nous utilisons la grammaire contenant les deux productions <math>S \rightarrow aSb</math> et <math>S \rightarrow \epsilon </math> (<math>\epsilon</math> pour ne rien consommer ou ajouter), <math>S</math> est l'axiome de la grammaire implicitement. |

|||

La trace de l'algorithme descendant du mot d'entrée "aabb" est alors : |

|||

== Projets 2024-2025 == |

|||

{| class="wikitable" |

|||

|- |

|||

! Pile |

|||

! Entrée |

|||

! Opération |

|||

|- |

|||

| S |

|||

| aabb |

|||

| |

|||

|- |

|||

| aSb |

|||

| aabb |

|||

| dériver par <math>S \rightarrow aSb</math> |

|||

|- |

|||

| Sb |

|||

| abb |

|||

| consommer a |

|||

|- |

|||

| aSbb |

|||

| abb |

|||

| dériver par <math>S \rightarrow aSb</math> |

|||

|- |

|||

| Sbb |

|||

| bb |

|||

| consommer a |

|||

|- |

|||

| bb |

|||

| bb |

|||

| dériver par <math>S \rightarrow \epsilon</math> |

|||

|- |

|||

| b |

|||

| b |

|||

| consommer b |

|||

|- |

|||

| |

|||

| |

|||

| consommer b et valider le mot |

|||

|- |

|||

|} |

|||

* [[Polyominos, pavages et solveurs SAT]] par ÉTienne MALABRE (tuteur: Pierre Hyvernat) |

|||

Malgré la simplicité de cette technique, deux problèmes majeurs sont présents et mènent tous deux à utiliser un ensemble restreint de règles de grammaire par rapport aux grammaires algébriques. |

|||

* [[Algorithmes de couplages parfaits et de mariages stables]] par Eddy GUYON (tuteur: Valentin Gledel) |

|||

* [[Stéganographie "BPC"]] par Hania BOUDJAJ (tuteur: Pierre Hyvernat) |

|||

* [["tableau des suffixes" et transformée de Burrows-Wheeler]] par Benjamin BOGDAN (tuteur: Sébastien Tavenas) |

|||

* [[Jeu de la vie]] par Alexis ANTOINE (tuteur: Romain Negro) |

|||

* [[Modèle proie-prédateur sans équations]] par Lucas DELAMEZIERE (tuteur: Mouloud Kessar) |

|||

* [[Où placer une (ou plusieurs) antennes 5G dans un village ?]] par Nils BRIFFOD (tuteur: Dorin Bucur) |

|||

* [[Introduction à la complexité et sa formalisation]] par Mael ALBRECHT (tuteur: Tom Hirschowitz) |

|||

Le premier problème concerne la récursivité gauche. Si l'algorithme ne sait pas exactement comment choisir les productions à appliquer et que la grammaire possède des productions de la forme <math>N \rightarrow N\alpha</math> ou autrement dit des productions associant le même non-terminal à gauche et au début de le partie droite de la production, alors la dérivation du sommet d'une proto-phrase contenant <math>N</math> mènera toujours à avoir le même non-terminal au sommet et l'algorithme ne pourra jamais arrêter de dériver. |

|||

== Projets 2023-2024 == |

|||

<ul> |

|||

<li> <math> N </math> </li> |

|||

<li> <math> N\alpha </math> </li> |

|||

<li> <math> N\alpha\alpha </math> </li> |

|||

<li> <math> N\alpha\alpha\alpha </math> </li> |

|||

<li> <math> N\alpha\alpha\alpha\alpha </math> </li> |

|||

<li> … </li> |

|||

</ul> |

|||

* [[Calcul approché de l'élément majoritaire, et autres algorithmes approchés]] par Teva PHILIPPE (tuteur: Pierre HYVERNAT) |

|||

Pour contrer ce problème il existe une méthode permettant de transformer la récursivité gauche en une récursivité droite d'un non-terminal secondaire : |

|||

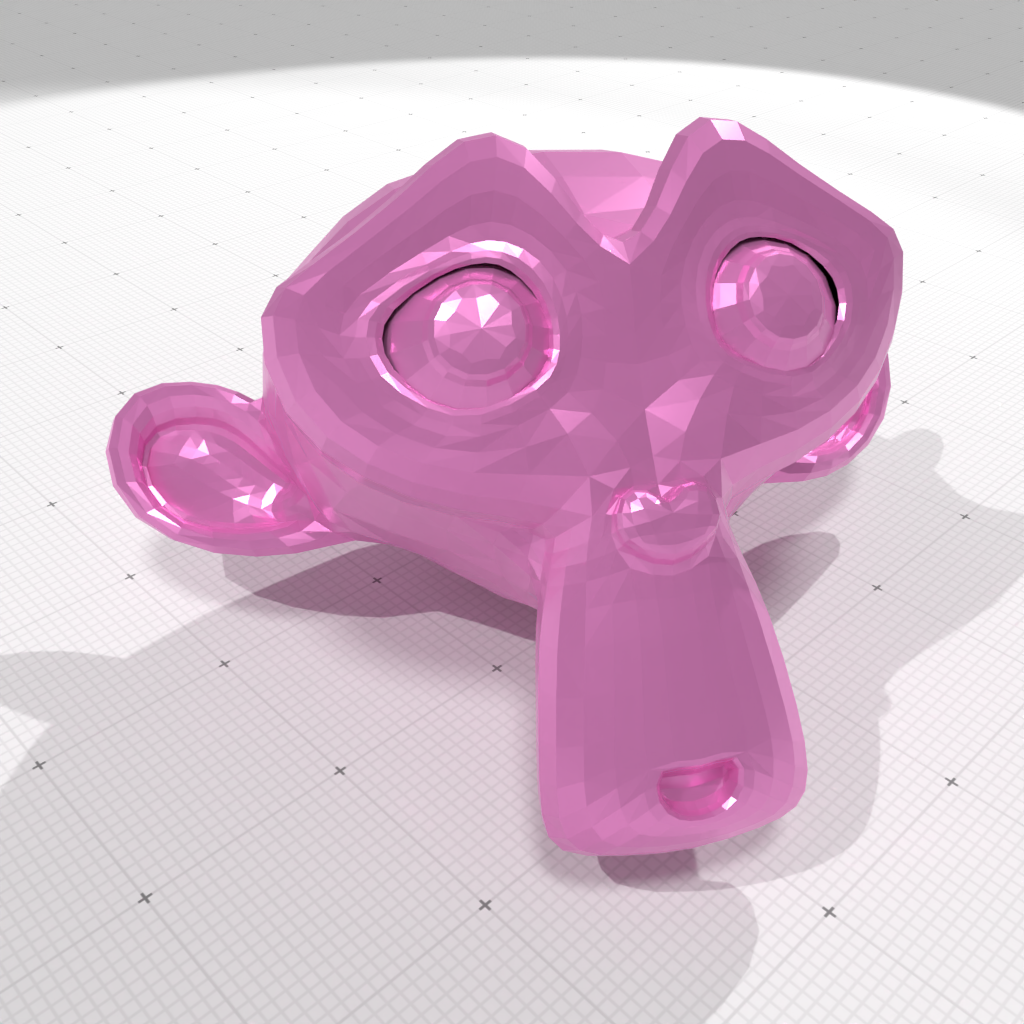

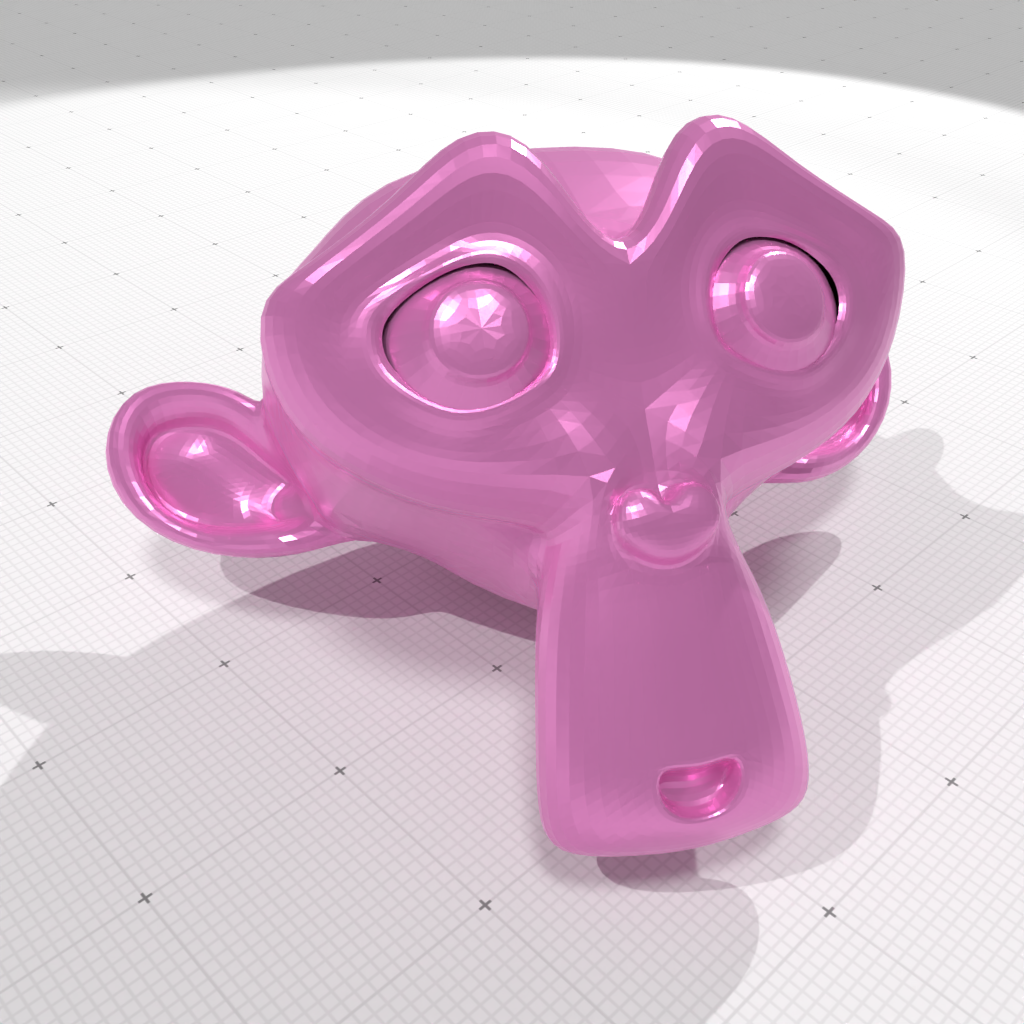

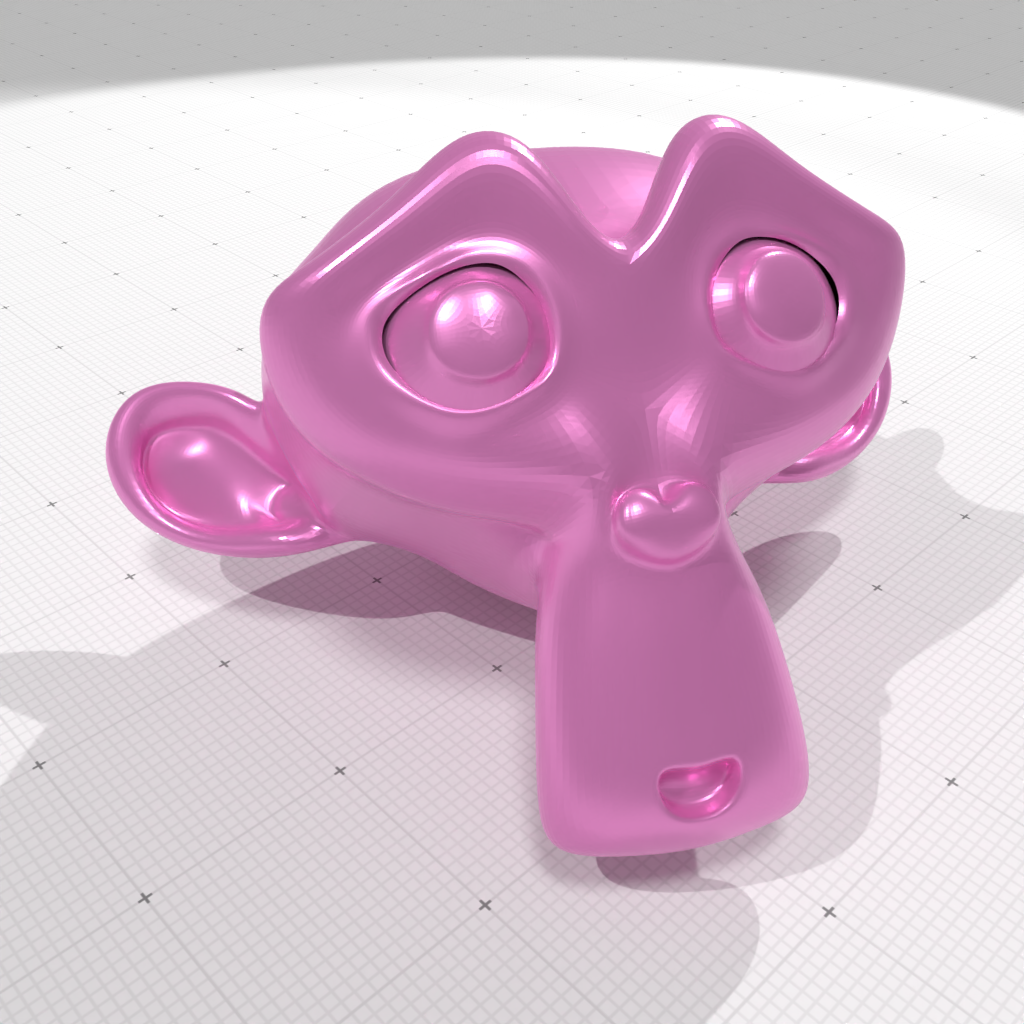

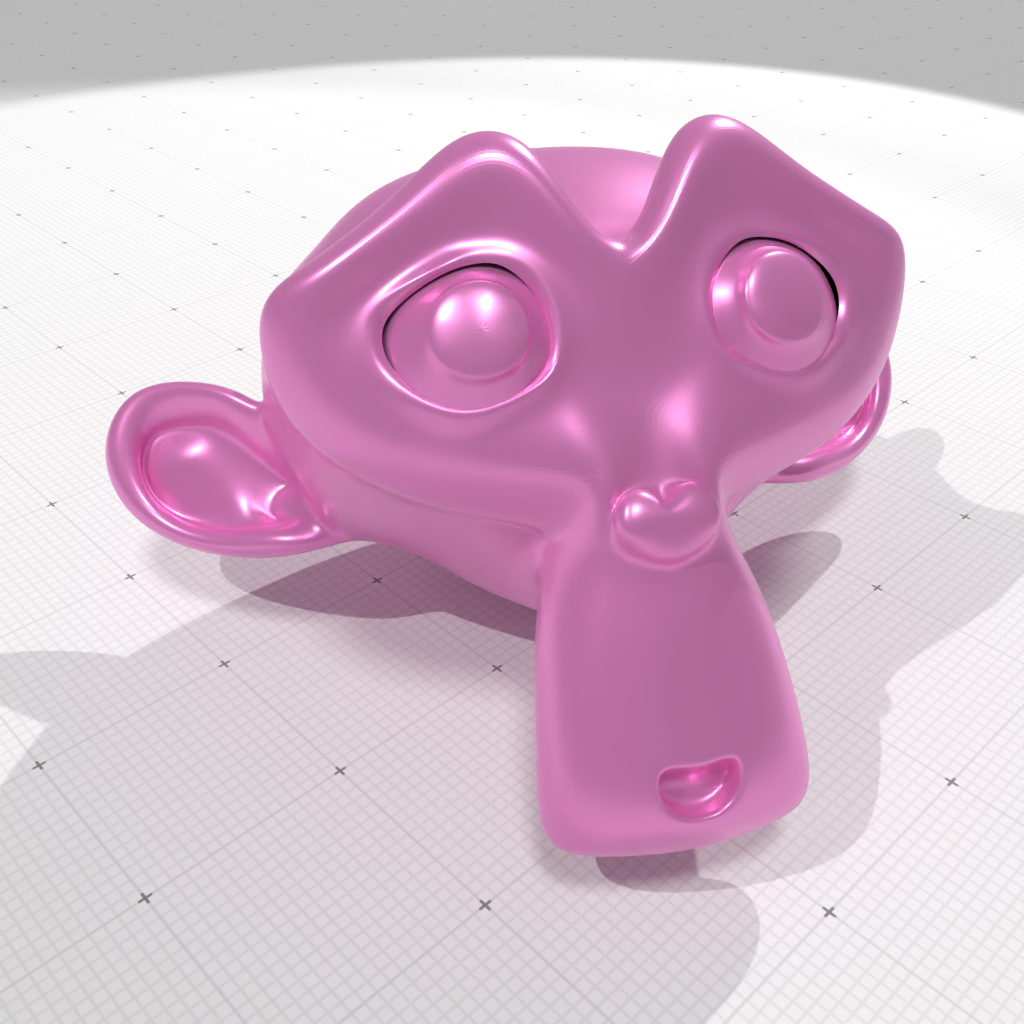

* [[Surfaces polygonales et surfaces de subdivision]] par Vetea STOLL (tuteur: Jacques-Olivier LACHAUD) |

|||

* [[Calcul des valeurs de Grundy pour des jeux octaux]] par Mathieu BRUNOT (tuteur: Valentin GLEDEL) |

|||

* [[Cryptanalyse informatique de quelques systèmes de chiffrement "historiques"]] par Gabriel ESAT (tuteur: Pierre HYVERNAT) |

|||

* [[Implémentation d'une IA pour le jeu Puissance 4 à l'aide de l'algorithme alpha-beta]] par Chloé FAUCON (tuteur: Valentin GLEDEL) |

|||

* [[Modélisation de la ruine du joueur]] par Albert KULAS (tuteur: Céline LABART) |

|||

* [[Calibration de caméra et reconstruction 3D]] par Noah CUNEO (tuteur: Stéphane BREUILS) |

|||

Soit <math>N \rightarrow N\alpha</math> <math>N \rightarrow \beta</math> |

|||

== Projets 2022-2023 == |

|||

<ul> |

|||

<li> <math>N \rightarrow \beta N'</math> </li> |

|||

<li> <math>N' \rightarrow \alpha N'</math> </li> |

|||

<li> <math>N' \rightarrow \epsilon </math> </li> |

|||

</ul> |

|||

* [[media:Mcmanus-2023.pdf|Programmation du robot NAO]] par Ronan MCMANUS (Tuteur : Christophe CARMAGNAC) |

|||

En effet, les règles initiales mènent intuitivement aux motifs de la forme <math>\beta \alpha \alpha \alpha ...\alpha</math>. Remplacer la récursivité gauche consisterait en réécrire les règles donnant les mêmes motifs, soit <math>\beta</math> en préfixe suivi d'une règle linéaire droite pour les <math>\alpha</math>. |

|||

* [[media:Cusumano-2023.pdf|Vision en relief, anaglyphes et auto-stéréogrammes à partir d'images RGB+profondeur]] par Lilian CUSUMANO (Tuteur : Jacques-Olivier LACHAUD) |

|||

* Tables de hachage et dictionnaires par Morgane FAREZ (Tuteur : Pierre HYVERNAT) |

|||

* Réductions de problèmes par Solène BELISSARD (Tuteur : Pierre HYVERNAT) |

|||

* Détection d’anomalies en « temps réel » via la plateforme de streaming d’évènements Kafka par Franz-Maximilien CERON (Tuteur : David TELISSON) |

|||

* [[media:Kant-aliagas-2023.pdf|Recherche de chemin en temps réel par A*]] par Cassandre KANT-ALIAGAS (Tuteur : Lucas CHARDONNET) |

|||

* [[media:Gossin-2023.pdf|Rendu rapide de scènes 3D]] par Cassiopée GOSSIN (Tuteur : Colin WEILL-DUFLOS) |

|||

* [[media:Moiroud-2023.pdf|Détection de droites dans les images avec la transformée de Hough]] par Elliott MOIROUD (Tuteur : Stéphane BREUILS) |

|||

* [[media:Rexhepi-2023.pdf|Stratégies mixtes et programmation linéaire par Ilirian REXHEPI]] (Tuteur : Sébastien TAVENAS) |

|||

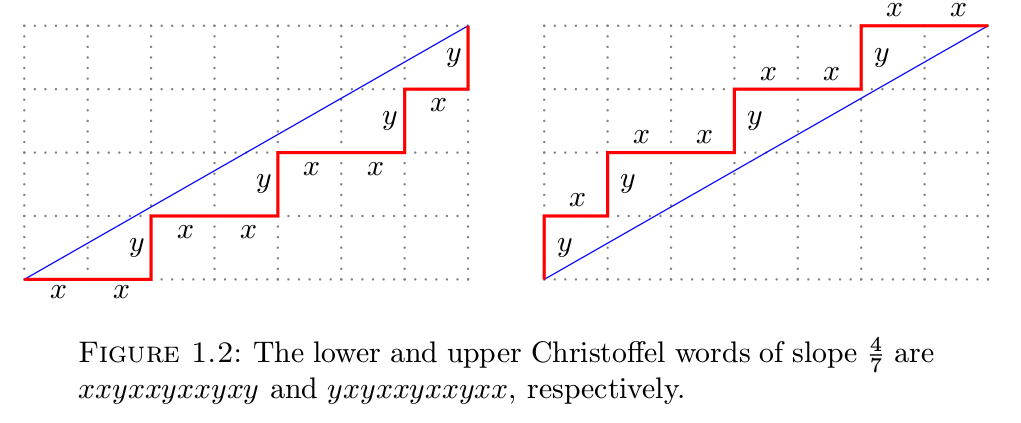

* [[media:Rey-2023.pdf|Géométrie discrète, Convexité des polyominos, Combinatoire des mots]] par Lukas REY (Tuteur : Jacques-Olivier LACHAUD) |

|||

== Projets 2021-2022 == |

|||

Le second problème des analyseurs descendant et le déterminisme lors du choix des productions à dériver. L'algorithme doit dériver un non-terminal selon la production qui à le plus de chance de réussir l'analyse. Dans l'exemple de la trace de l'analyse du mot "aabb", il fallait lors de la troisième dérivation dériver selon <math>S \rightarrow \epsilon</math> seulement. |

|||

* [[ Détection d’anomalies par Isolation Forest : application pour l’industrie 4.0]] par Mila DESMET (Tuteur : David TELISSON) |

|||

Dans le cas contraire non-déterministe, l'algorithme pourrait autoriser de revenir en arrière dans l'analyse lors d'erreur et d'appliquer les productions restantes jusqu'à ne plus avoir de production et donc signaler une véritable erreur. |

|||

* [[Machines de Turing]] par Emeline CHOLLET (Tuteur : François BOUSSION) |

|||

* [[Géométrie discrète, Convexité des polyominos, Combinatoire des mots]] par Joris DUBOIS (Tuteur: Jacques-Olivier LACHAUD) |

|||

* [[Origami, axiomes de Huzita/Justin et ReferenceFinder]] par Mathys AUBERT (Tuteur : Pierre HYVERNAT) |

|||

* [[Les "claviers"]] par Amélie HACQUE (Tuteur : Pierre HYVERNAT) |

|||

* [[Fractales de Newton et sensibilité aux conditions initiales]] par Paul SCHULTZ (Tuteur: Jacques-Olivier LACHAUD) |

|||

* [[Approximation numérique de calculs intégraux]] par Enzo MAUTI (Tuteur : Dionysos GRAPSAS) |

|||

* [[Instant Insanity]] par Numa Ciribino (Tuteur : Sébastien TAVENAS) |

|||

* [[Automates cellulaires]] par Mattéo LUQUE (Tuteur : Gérald CAVALLINI et Jacques-Olivier LACHAUD) |

|||

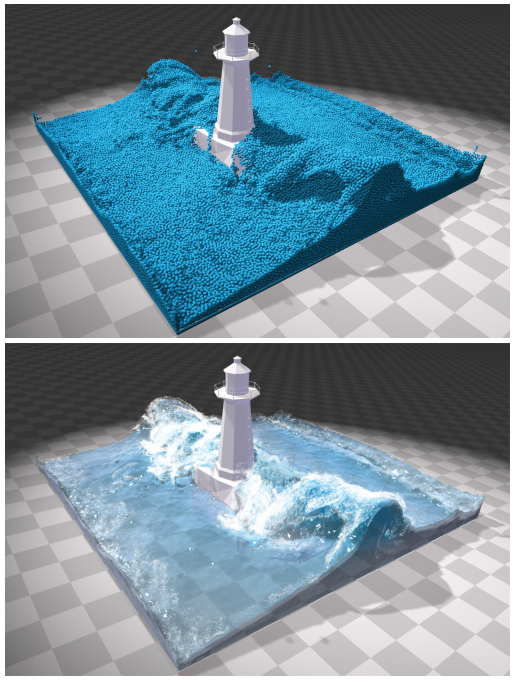

* [[Simulation de fluides]] par Maxime ROUSSEAU (Tuteur : Colin WEILL-DUFLOS) |

|||

== Projets 2020-2021 == |

|||

==== Les analyseurs à symbole de prévision ==== |

|||

* [http://os-vps418.infomaniak.ch:1250/mediawiki/index.php/Utilisateur:Maxent_Bernier#Transform.C3.A9e_en_distance_discr.C3.A8te.2C_diagramme_de_Voronoi_discret.2C_axe_m.C3.A9dian_et_squelette Transformée en distance discrète, diagramme de Voronoi discret, axe médian et squelette] par Maxent BERNIER (Tuteur : Jacques-Olivier LACHAUD) |

|||

* [[Clustering par K-means, segmentation d'image]] par Paul AUBRY (Tuteur : Jacques-Olivier LACHAUD) |

|||

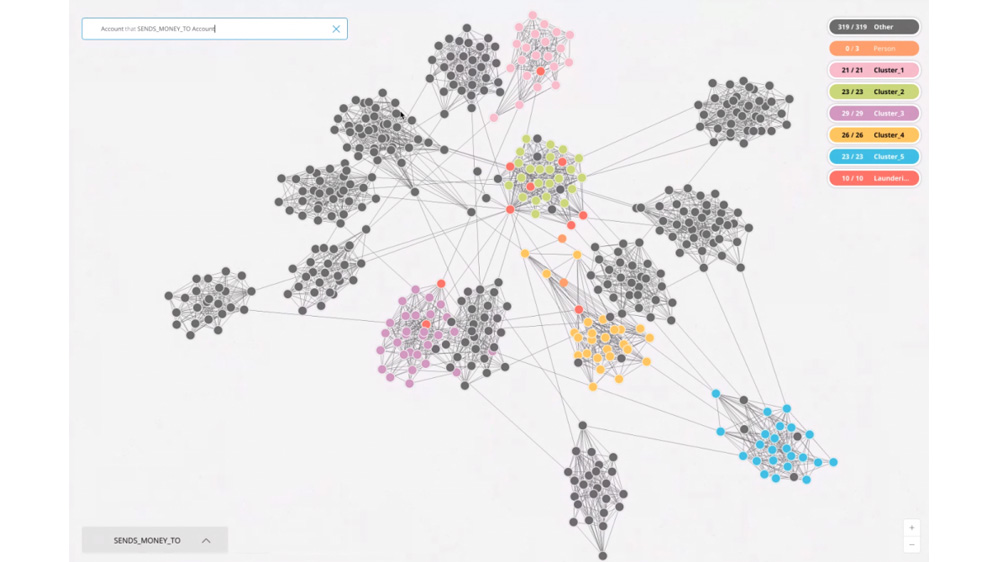

* [http://os-vps418.infomaniak.ch:1250/mediawiki/index.php/Base_de_donn%C3%A9es_orient%C3%A9es_Graphe,_similarit%C3%A9_et_recommandation Base de données orientées Graphe, similarité et modèles prédictifs] par Luca Policastro (Tuteur : Gérald Cavallini) |

|||

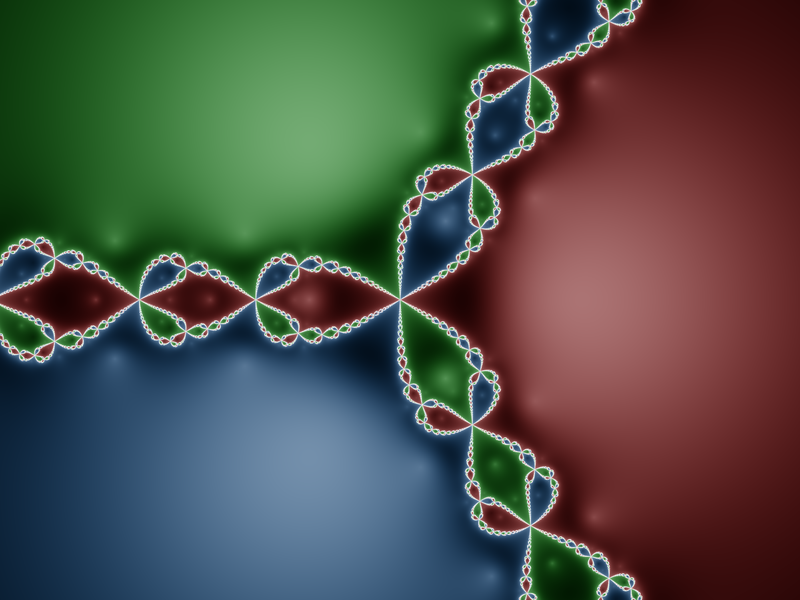

* [http://os-vps418.infomaniak.ch:1250/mediawiki/index.php/Ensemble_de_Mandelbrot_et_autres_fractales Ensemble de Mandelbrot et autres fractales] par Andrien MONTMAYEUR (Tuteur : Pierre Hyvernat) |

|||

* Complexité pratique contre complexité théorique |

|||

* [[Etude du protocole gRPC]] par Alexandre Desbos (Tuteur : David Télisson) |

|||

* [[Valeurs de Sprague-Grundy pour le jeu de Wythoff]] par Nolann SANMARTI (Tuteur : Sébastien Tavenas) |

|||

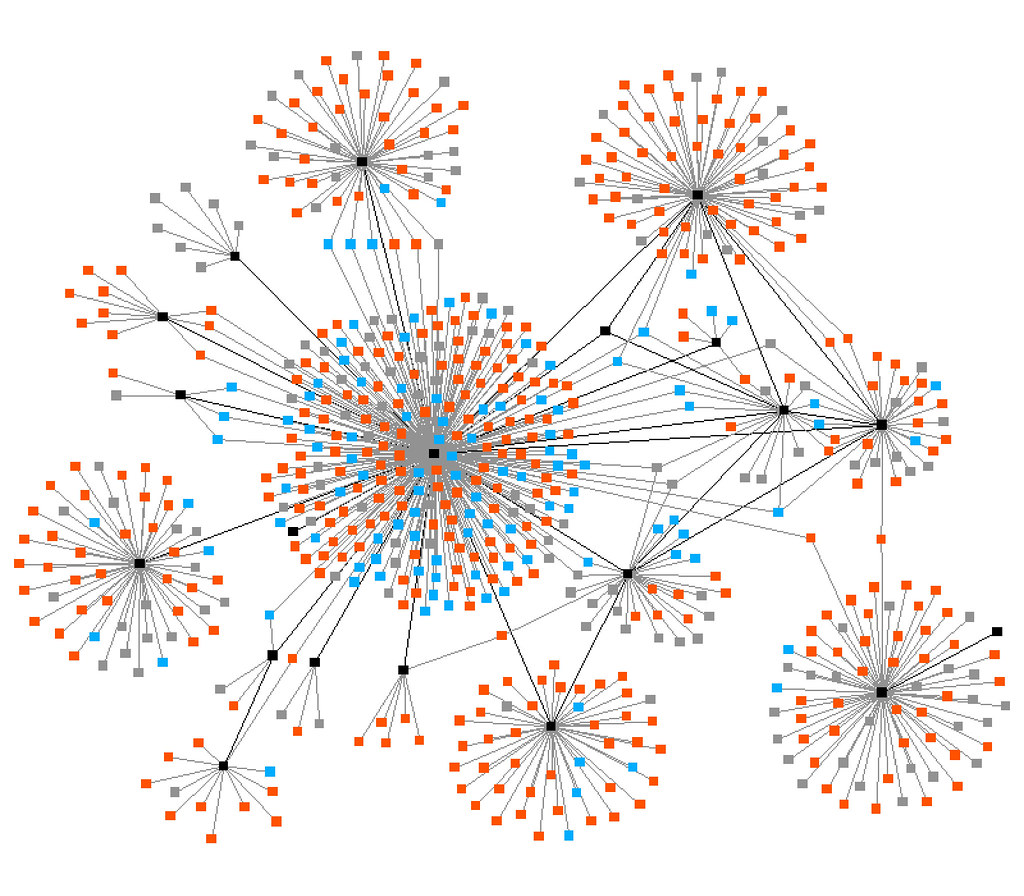

* [[Modélisation de réseaux sociaux, base de données orientées graphe]] par Baptiste Griva (Tuteur : Gerald Cavallini) |

|||

* [http://os-vps418.infomaniak.ch:1250/mediawiki/index.php/Mod%C3%A9lisation_de_la_ruine_du_joueur Modélisation de la ruine du joueur] par Emilien Boitouzet (Tuteur : Céline Labart) |

|||

== Projets 2019-2020 == |

|||

Un analyseur à symbole de prévision, nommé LL(k) ou k est le nombre de symboles, lors d'une dérivation va lire k symboles au début de la chaine d'entrée pour déterminer la production à dériver contenant ces k symboles en préfixe. La plupart des analyseurs se contentent de 1 symbole de prévision. |

|||

* [http://os-vps418.infomaniak.ch:1250/mediawiki/index.php/Transform%C3%A9e_Burrows_Wheeler Compression et transformée de Burrow-Wheeler] par Simon LEONARD (Tuteur : Pierre HYVERNAT) |

|||

En amont de l'analyse un algorithme est utilisé pour générer une table de la forme <math>PRODUCTION(N, c) \rightarrow P</math>. |

|||

* [http://os-vps418.infomaniak.ch:1250/mediawiki/index.php/VISI201_Backtracking_(PICHENOT_Simon) Backtracking] par Simon PICHENOT (Tuteur : Pierre HYVERNAT) |

|||

<ul> |

|||

* [http://os-vps418.infomaniak.ch:1250/mediawiki/index.php/Transport_optimal_par_coupe_1D_et_transfert_de_couleurs_entre_images_avec_numpy Transfert de couleur (version 2)] par Florian DUFAURE (Tuteur : Jacques-Olivier LACHAUD) |

|||

<li> <math>N</math> : Le non-terminal courant (au sommet de la proto-phrase). </li> |

|||

* [[Génération fractale de terrains]] par Hugo REY (Tuteur : Jacques-Olivier LACHAUD) |

|||

<li> <math>c</math> : Le lexème courant (au sommet de la chaine d'entrée) utilisé comme préfixe. </li> |

|||

* [http://os-vps418.infomaniak.ch:1250/mediawiki/index.php/Architectures_Orient%C3%A9es_Micro-Services#Architecture_orient.C3.A9e_micro-services Architectures Orientées Micro-Services] par Romain NEGRO (David TELISSON) |

|||

<li> <math>P</math> : la production ayant pour préfixe <math>c</math> </li> |

|||

* [[Apprentissage automatique]] par Evan L'HUISSIER (Tuteur : Tom HIRSCHOWITZ) |

|||

</ul> |

|||

* [[Algorithmes probabilistes/déterministes pour tester la primalité d'un entier]] par Juliette NEYRAT (Tuteur : Sébastien TAVENAS) |

|||

* [[Base de données orientées Graphe et similarité]] par Romain PAJEAN (Gérald CAVALLINI) |

|||

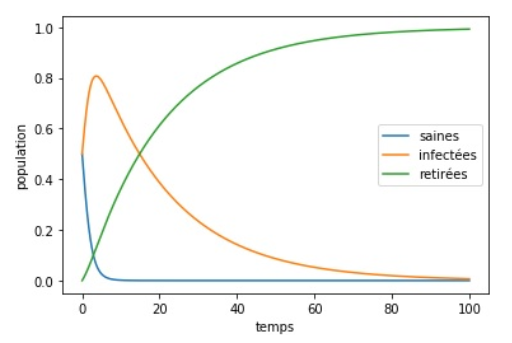

* [[Modèles d'évolution de populations]] par Théo GUESDON (Tuteur : Jimmy GARNIER) |

|||

== Projets 2018-2019 == |

|||

Dans le cas de productions sans <math>\epsilon</math>, l'algorithme va pour chaque non-terminal lire toutes les productions associées. Pour chacune des productions déterminer les préfixes possibles, en parfois dérivant jusqu'à obtenir un terminal à gauche, puis associer cette production avec ses préfixes dans la table. |

|||

* [[Transport optimal par coupe 1D et transfert de couleurs entre images]] par Lucas CHARDONNET (Tuteur : Jacques-Olivier LACHAUD) |

|||

Dans l'exemple d'une grammaire reconnaissant les déclarations de variables avec initialisation optionnelle par les règles suivantes : |

|||

* [[Génération et résolution de labyrinthes II]] par Romain THEODET (Tuteur : François BOUSSION) |

|||

* [[Rest & Pub-Sub : protocole hybride pour l'IoT]] par Ewan RAKOTOANOSY (Tuteur : David TELISSON) |

|||

* [[La suite de Conway et la classification périodique des "éléments"]] par Yohann THEPAUT (Tuteur : Pierre HYVERNAT) |

|||

* [[Initiation à la démonstration sur ordinateur et certification de logiciel]] par Loïc DORNET (Tuteur : Tom HIRSCHOWITZ) |

|||

* [[Dilemme du prisonnier]] par Christophe CARMAGNAC (Tuteur : Gérald CAVALLINI) |

|||

== Projets 2017-2018 == |

|||

<ul> |

|||

<li> <math>decl \rightarrow type\,id\,decl'</math> </li> |

|||

<li> <math>decl' \rightarrow =\, expr\,;</math> </li> |

|||

<li> <math>decl' \rightarrow ; </math> </li> |

|||

</ul> |

|||

* [[VISI201 Analyse syntaxique (Tristan Porteries, 2018)]] par Tristan PORTERIES (Tuteur : Pierre HYVERNAT) |

|||

Cette grammaire reconnait les mots "int i = 0;" et "int i;" de la façon suivante : |

|||

* [[Segmentation d'image par détection de contours et algorithme "ligne de partage des eaux"]] par Nils RUET (Tuteur : Jacques-Olivier LACHAUD) |

|||

* [[Fouille de données textuelles à partir des "Exercices de style" de R. Queneau]] par Rémi BOUVIER (Tuteur : Laurent VUILLON) |

|||

* [[Transformées en distance, diagramme de Voronoi et applications en geometry processing]] par Robin WAGNER (Tuteur : Jacques-Olivier LACHAUD) |

|||

* [[Pavages de Penrose]] par Brunelle CORDIER-PIERRE-BES (Tuteur : Pierre HYVERNAT) |

|||

<ul> |

|||

<li> Dérivation de l'axiome : <math>type\,id\,decl'</math></li> |

|||

<li> Reconnaissance de <math>type</math> et <math>id</math> par respectivement "int" et "i"</li> |

|||

<li> Dérivation de <math>decl'</math> par l'une de ses productions</li> |

|||

<li> Suite de l'analyse avec l'une des deux productions de <math>decl'</math> </li> |

|||

</ul> |

|||

== Projets 2016-2017 == |

|||

Ici est mis en évidence le branchement lors de la dérivation de <math>decl'</math>, la table des productions par symbole de prévision est : |

|||

* [[Algorithme de rendu de scène 3D par Z-buffer]] par Raphaël TOURNAFOND (Tuteur : Jacques-Olivier LACHAUD) |

|||

{| class="wikitable" |

|||

* [[Traitement d'image]] par Ambroise DECOUTTERE (Tuteur : Jacques-Olivier LACHAUD) |

|||

|- |

|||

* [[Nim et la théorie des jeux impartiaux]] par Luca CHAPELLE (Tuteur : Pierre HYVERNAT) |

|||

! Non-terminal |

|||

* [[Calculabilité et modèles de calcul]] par Thibaut CHAMINADE (Tuteur : Rodolphe LEPIGRE) |

|||

! Préfixe |

|||

* [[Génération et résolution de labyrinthes]] par Candice ROBERT (Tuteur : Xavier PROVENCAL) |

|||

! Production |

|||

|- |

|||

| <math>decl</math> |

|||

| <math>type</math> |

|||

| <math>decl \rightarrow type\,id\,decl'</math> |

|||

|- |

|||

| <math>decl'</math> |

|||

| = |

|||

| <math>decl' \rightarrow =\,expr\,;</math> |

|||

|- |

|||

| <math>decl'</math> |

|||

| ; |

|||

| <math>decl' \rightarrow ;</math> |

|||

|- |

|||

|} |

|||

Lors de la dérivation de <math>decl'</math>, l'analyseur va interroger la table de production pour le lexème en sommet d'entrée, dans le cas des deux mots "int i = 0;" et "int i;" ce symbole sera respectivement "=" ou ";". Ces deux symboles donnent dans la table deux productions valide pour continuer l'analyse. |

|||

= Archive des projets proposés = |

|||

Dans le cas où le préfixe n'est pas associer à une production, l'analyseur peut signaler une erreur car cela signifie que n'importe quelle dérivation mènera à une erreur lors de la reconnaissance du premier symbole terminal. |

|||

== Sujets proposés 2024-2025 == |

|||

En ce qui concerne les grammaires possédant des productions en <math>\epsilon</math>, ces productions sont valide pour n'importe quelle préfixe mais sont soumise à une condition supplémentaire sur les symboles rencontrés après l'usage des non-terminaux de ces productions. |

|||

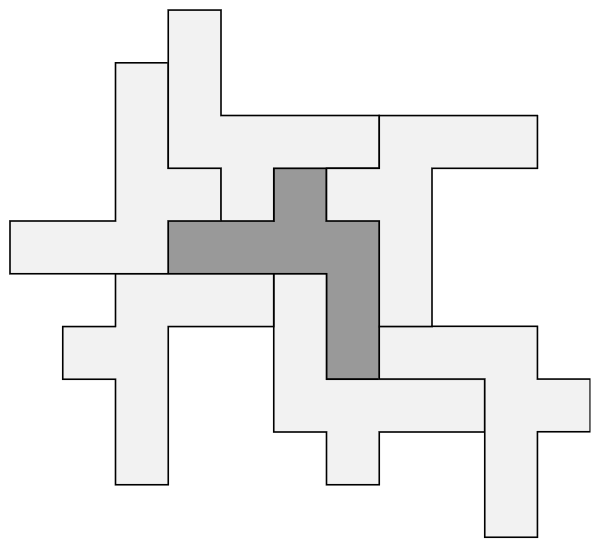

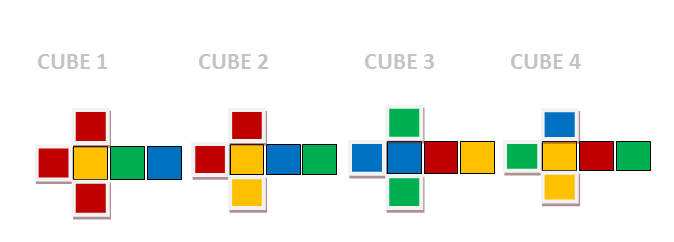

=== [[Polyominos, pavages et solveurs SAT]] === |

|||

Soit une production <math>N \rightarrow \epsilon</math>, nous regardons toutes les productions utilisant le non-terminal <math>N</math> de la forme <math>L \rightarrow N\gamma</math> et associant dans la table la production <math>N \rightarrow \epsilon</math> avec tous les préfixes de <math>\gamma</math>. |

|||

'''Tuteur :''' Pierre Hyvernat |

|||

Dans le même exemple de grammaire reconnaissant les déclarations de variables, les règles peuvent s'écrire : |

|||

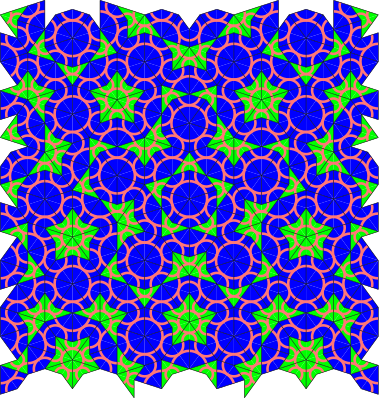

'''Résumé :''' les polyominos sont, comme les pièces de Tetris, des assemblages de petits carrés collés par leurs bords. Un ensemble de polyomino ''pavent'' une forment lorsqu'on peut la remplir avec des ces polyominos, sans chevauchement et sans trou. Il existe des algorithmes spécifiques pour vérifier si on peut paver une forme, mais il est également possible de transformer la question en une grosse formule booléenne qui exprime que chaque case se retrouve bien recouverte, que chaque polyomino a bien la bonne forme, etc. On peut alors utiliser un ''solveur SAT'' qui cherche les solutions pour une telle formule. |

|||

<ul> |

|||

<li> <math>decl \rightarrow type\,id\,decl'\,;</math> </li> |

|||

<li> <math>decl' \rightarrow =\,expr</math> </li> |

|||

<li> <math>decl' \rightarrow \epsilon </math> </li> |

|||

</ul> |

|||

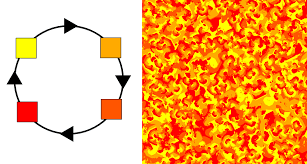

En écrivant des formules un peu plus complexes, on peut essayer de calculer le nombre de [https://en.wikipedia.org/wiki/Heesch%27s_problem Heesch's problem] d'un polyomino. Il s'agit du nombre d'anneaux que l'on peut mettre autour d'un polyomino donné. Par exemple, la figure suivante montre un polyomino avec nombre de Heesh égal à 1 : le polyomino est entouré d'un anneau (composé de copies de lui même), et on ne peut pas ajouter de second anneau supplémentaire (sans chevauchement et sans trou). |

|||

Le non-terminal associé à la production <math>decl' \rightarrow \epsilon </math> et utilisé seulement dans <math>decl \rightarrow type\,id\,decl'\,;</math> et le symbole suivant <math>delc'</math> est ";". <math>decl' \rightarrow \epsilon </math> et donc associé à ";" dans la table comme pour la grammaire précédente sans productions utilisant <math>\epsilon</math>. |

|||

[[File:heesch.png|200px]] |

|||

{| class="wikitable" |

|||

|- |

|||

! Non-terminal |

|||

! Préfixe |

|||

! Production |

|||

|- |

|||

| <math>decl</math> |

|||

| <math>type</math> |

|||

| <math>decl \rightarrow type\,id\,decl'\,;</math> |

|||

|- |

|||

| <math>decl'</math> |

|||

| = |

|||

| <math>decl' \rightarrow =\,expr</math> |

|||

|- |

|||

| <math>decl'</math> |

|||

| ; |

|||

| <math>decl' \rightarrow \epsilon</math> |

|||

|- |

|||

|} |

|||

Le plus grand nombre de Heesh fini connu est ... 6 ! (Mais il n'est pas atteint par un polyomino.) |

|||

=== Les analyseurs ascendants === |

|||

Le principe de l'analyse ascendante est de réduire successivement une phrase correspondant à la chaine d'entrée jusqu'à obtenir l'axiome de la grammaire. Ce type d'analyseur nécessite la création en amont d'une table d'analyse difficilement concevable manuellement. |

|||

'''Objectifs :''' |

|||

Cette table d'analyse se base sur deux opérations, réduire et décaler. Décaler consiste à déplacer un terminal en sommet de la chaine d'entrée dans la pile d'analyse, réduire consiste à remplacer le sommet de la pile d'analyse correspondant à la partie droite d'une production par le non-terminal associé à cette production. |

|||

# Comprendre l'utilisation d'un solveur SAT, par exemple en codant la résolution de sudoku. |

|||

Pour la grammaire suivante et le mot d'entrée "aabb" : |

|||

# Coder (en Python ?) la génération de la formule associée à un problème de pavage, et la transformation d'une solution booléenne en image finale. |

|||

# Coder (en Python ?) la génération de la formule associée à la question "le nombre de Heesh de ce polyomino est au moins égal à H", et la transformation d'une solution en image finale. |

|||

<ul> |

|||

<li><math> S \rightarrow aSb </math></li> |

|||

<li><math> S \rightarrow ab </math></li> |

|||

</ul> |

|||

La trace de l'analyse ascendante est : |

|||

'''Référence :''' |

|||

{| class="wikitable" |

|||

|- |

|||

! Pile |

|||

! Entrée |

|||

! Opération |

|||

|- |

|||

| |

|||

| aabb |

|||

| |

|||

|- |

|||

| a |

|||

| abb |

|||

| décaler |

|||

|- |

|||

| aa |

|||

| bb |

|||

| décaler |

|||

|- |

|||

| aab |

|||

| b |

|||

| décaler |

|||

|- |

|||

| aS |

|||

| b |

|||

| réduire par <math> S \rightarrow ab </math> |

|||

|- |

|||

| aSb |

|||

| |

|||

| décaler |

|||

|- |

|||

| S |

|||

| |

|||

| réduire par <math> S \rightarrow aSb </math> et valider |

|||

|- |

|||

|} |

|||

# <tt>TODO: ref sur les solveur SAT</tt> |

|||

Malheureusement il ne suffit pas de reconnaître la partie droite d'une production sur le sommet de la pile pour réduire par celle ci. |

|||

# G. Kaplan, Heesch Numbers of Unmarked Polyforms : [https://isohedral.ca/heesch-numbers-of-unmarked-polyforms/ blog], [https://arxiv.org/pdf/2105.09438 article] |

|||

Le contre-exemple est le suivant : |

|||

Soit une grammaire linéaire droite de la forme <math>A \rightarrow aA</math>, <math>A \rightarrow a</math> et le mot "aa". |

|||

En premier "a" est décalé, puis réduit par la production <math>A \rightarrow a</math>, puis le second "a" est décalé pour obtenir sur la pile d'analyse "Aa". Aucune production n'a le motif "Aa" en partie droite pourtant le mot "aa" est bien valide intuitivement. Pour réussir cette analyse il aurait fallu décaler les deux "a" pour obtenir "aa", réduire le dernier en "aA" selon <math>A \rightarrow a</math> et enfin réduire en "A" selon <math>A \rightarrow aA</math>. |

|||

=== [[Algorithmes de couplages parfaits et de mariages stables]] === |

|||

Les réductions valide sont nommées manche, ils dépendent de l'état de la pile. |

|||

'''Tuteur :''' Valentin Gledel |

|||

==== Les tables d'analyse ==== |

|||

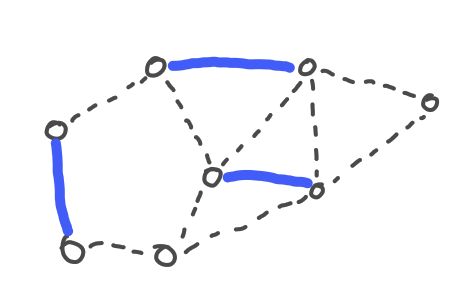

'''Résumé :''' Un [https://fr.wikipedia.org/wiki/Th%C3%A9orie_des_graphes graphe] est un ensemble de sommets et un ensemble d’arêtes sur ces sommets. Un [https://fr.wikipedia.org/wiki/Couplage_(th%C3%A9orie_des_graphes) couplage] dans un graphe est un ensemble d'arêtes C, tels que toute paire d'arête de C n'a aucun sommet en commun. Un couplage est dit parfait s'il touche tous les sommets du graphe. |

|||

La table d'analyse représente les différents états de l'automate à pile formant l'analyseur, ces états sont calculés en se basant sur la notion d'item de production. |

|||

<table> |

|||

Un item de production représente l'état actuel de validation d'une production, ou autrement dit, le nombre de symboles validés lors de l'analyse. |

|||

<tr> |

|||

<td>[[File:Graph.jpg|300px]]</td> |

|||

<td>[[File:Matching1.jpg|300px]]</td> |

|||

<td>[[File:Matching2.jpg|300px]]</td> |

|||

</tr> |

|||

<tr> |

|||

<td>Un graphe</td> |

|||

<td>Un couplage dans ce graphe</td> |

|||

<td>Un couplage parfait dans ce graphe</td> |

|||

</tr> |

|||

</table> |

|||

Pour une production de la forme <math>N \rightarrow \alpha \gamma \beta</math> il existe 4 items, en cas générale il existe n + 1 items pour une production de n symboles en partie droite. Ces items sont notés : |

|||

<ul> |

|||

<li><math>N \rightarrow \bullet \alpha \gamma \beta</math></li> |

|||

<li><math>N \rightarrow \alpha \bullet \gamma \beta</math></li> |

|||

<li><math>N \rightarrow \alpha \gamma \bullet \beta</math></li> |

|||

<li><math>N \rightarrow \alpha \gamma \beta \bullet</math></li> |

|||

</ul> |

|||

Les algorithmes d'[https://fr.wikipedia.org/wiki/Algorithme_d%27Edmonds_pour_les_couplages Edmonds] et de [https://fr.wikipedia.org/wiki/Algorithme_de_Hopcroft-Karp Hopcroft-Karp] sont des algorithmes de recherche de couplage dans des graphes. |

|||

Par exemple l'item <math>N \rightarrow \alpha \bullet \gamma \beta</math> signifie que l'analyse à reconnu <math>\alpha</math> et espère reconnaître <math>\gamma \beta</math>. Le dernier item <math>N \rightarrow \alpha \gamma \beta \bullet</math> signifie que tous les symboles de la productions ont été reconnu et donc la production peut servir de réduction. |

|||

Si le graphe que dans lequel on cherche un couplage correspond à un graphe d'affectation avec des préférences, on se retrouve dans le cas du [https://fr.wikipedia.org/wiki/Probl%C3%A8me_des_mariages_stables problème des mariages stables]. C'est par exemple le cas de l'affectation des places dans l'enseignement supérieur où il faut affecter des étudiants dans les différents établissements de tels sorte à respecter les choix des étudiants et des établissements. L'[https://fr.wikipedia.org/wiki/Algorithme_de_Gale_et_Shapley algorithme de Gale et Shapley] permet de résoudre efficacement ce problème. |

|||

Tout d'abord pour pouvoir d'écrire des items de l'axiome de la grammaire, nous devons définir une grammaire augmenté similaire à la grammaire initiale mais avec l'adjonction d'un non-terminal <math>S'</math> et de la production <math>S' \rightarrow S</math>. Ainsi l'état initiale de l'analyse est décrit par <math>S' \rightarrow \bullet S</math>, aucun symbole n'est reconnu. |

|||

Dans ce sujet, il est proposé de ce pencher sur ces différents problèmes et d'implémenter les algorithmes de résolutions présentés. |

|||

Deux fonctions vont être utilisées sur ces items, en particulier sur des ensembles d'items. La fonction <math>Fermeture(X)</math> et <math>Transition(X, c)</math>. |

|||

'''Objectifs :''' |

|||

<math>Fermeture(X)</math> prend en argument un ensemble d'item. |

|||

# comprendre le problème du mariage stable, |

|||

Soit un item <math>N \rightarrow \gamma \bullet \alpha</math> de <math>X</math>, si <math>\alpha</math> est un terminal alors ajouter cet item dans le résultat, sinon si <math>\alpha</math> est un non-terminal alors concaténer au résultat <math>Fermeture(Y)</math> où <math>Y</math> et l'ensemble de toutes les items des productions de <math>\alpha</math> avec le point en première position : <math>\{\alpha \rightarrow \bullet \beta, \alpha \rightarrow \bullet \delta, ...\}</math> |

|||

# implémenter les algorithmes de Gale-Shapley, |

|||

# implémenter les algorithmes de Hopcroft-Karp, |

|||

# comprendre la preuve de correction de l'algorithme de Hopcroft-Karp, |

|||

# implémenter l'algorithme d'Edmonds. |

|||

# éventuellement implémenter d'autres algorithmes liés aux couplages parfaits comme l'algorithme hongrois ou l'algorithme de Christofides. |

|||

=== [[Stéganographie "BPC"]] === |

|||

<math>Transition(X, c)</math> prend en argument un ensemble d'item et un terminal, Soit <math>N \rightarrow \alpha \bullet c \beta</math> de <math>X</math>, concaténer au résultat <math>Fermeture(\{N \rightarrow \alpha c \bullet \beta\})</math>. |

|||

'''Tuteur :''' Pierre Hyvernat |

|||

Ces deux fonctions vont permettre de déterminer les états de l'automates, chaque état et un ensemble d'items faisant partie de la collection canonique de l'analyseur. <math>Fermeture(S' \rightarrow \bullet S)</math> est l'état initiale <math>I_0</math> puis <math>Transition(X, c)</math> détermine tous les états atteignables par un décalage de c, et enfin un état où aucune transition n'est possible mais contenant un item de la forme <math>N \rightarrow \gamma \bullet</math> produira une réduction par <math>N</math>. |

|||

'''Résumé :''' la [https://fr.wikipedia.org/wiki/St%C3%A9ganographie stéganographie] consiste à dissimuler de l'information dans un message d'apparence anodine. On peut par exemple modifier légèrement les couleurs des pixels d'une image, on l'intensité des sons d'une fichier sonore de manière imperceptible par un humain. Les destinataires peuvent alors récupérer cette information caché en appliquant la méthode inverse. |

|||

<ul> |

|||

<li><math> S \rightarrow aSb </math></li> |

|||

<li><math> S \rightarrow ab </math></li> |

|||

</ul> |

|||

La méthode la plus simple consiste à utiliser le bit de poids faible des couleurs RVB de chaque pixel d'une image. La différence visuelle est tellement petite qu'on ne peut pas la distinguer à l’œil nu. Par exemple, les deux couleurs suivantes sont différentes uniquement sur les bits de poids faible des composantes RVB. |

|||

La grammaire ci-dessus produits les états suivant : |

|||

< |

<table> |

||

<tr> |

|||

<li><math>Fermeture(\{S' \rightarrow \bullet S\}) = \{ |

|||

<td>[[File:bleu1.png|100px]]</td> |

|||

S' \rightarrow \bullet S, |

|||

<td>[[File:bleu2.png|100px]]</td> |

|||

S \rightarrow \bullet aSb, |

|||

</tr> |

|||

S \rightarrow \bullet ab |

|||

<tr> |

|||

\} = I_0</math></li> |

|||

<td>#237fd1</td> |

|||

<li><math>Transition(I_0, S) = \{ |

|||

<td>#227ed0</td> |

|||

S' \rightarrow S \bullet |

|||

</tr> |

|||

\} = I_1</math></li> |

|||

</table> |

|||

<li><math>Transition(I_0, a) = \{ |

|||

S \rightarrow a \bullet Sb, |

|||

S \rightarrow a \bullet b, |

|||

S \rightarrow \bullet aSb, |

|||

S \rightarrow \bullet ab |

|||

\} = I_2</math></li> |

|||

<li><math>Transition(I_2, S) = \{ |

|||

S \rightarrow aS \bullet b |

|||

\} = I_3</math></li> |

|||

<li><math>Transition(I_2, a) = I_2</math></li> |

|||

<li><math>Transition(I_2, b) = \{ |

|||

S \rightarrow ab \bullet |

|||

\} = I_4</math></li> |

|||

<li><math>Transition(I_3, b) = \{ |

|||

S \rightarrow aSb \bullet |

|||

\} = I_5</math></li> |

|||

</ul> |

|||

Pour augmenter la quantité de données que l'on peut dissimuler, on peut utiliser les 2 bits de poids faible, ou les 3 bits de poids faible, etc. Plus on utilise de bits, plus les distorsions dans l'image deviennent visibles. Une manière plus intelligente est de ne remplacer des bits que dans les endroits "bruités" de l'image. Les distorsions deviennent alors plus difficiles à distinguer. C'est la stéganographie "complexité des plans de bits" (BPCS = "Bit Plane Complexity Steganography"). |

|||

L'automate résultant est le suivant : |

|||

Dans l'exemple suivant, l'intégralité des 9605 lignes / 37860 mots / 239347 octets (avant compression) de la pièce "Cyrano de Bergerac" est dissimulée dans l'image de gauche. |

|||

[[Fichier:Automate-lr.png|400px]] |

|||

<table> |

|||

=== Les arbres abstraits de syntaxe === |

|||

<tr> |

|||

<td>[[File:image-orig.png]]</td> |

|||

<td>[[File:LSBS.png]]</td> |

|||

<td>[[File:BPCS.png]]</td> |

|||

</tr> |

|||

<tr> |

|||

<td>image [https://pixabay.com/fr/photos/montagnes-lac-nature-paysage-hiver-8025144/ originale]<br>(320x240 pixels)</td> |

|||

<td>stéganographie LSB<br>(avec les 3 bits de poids faible)</td> |

|||

<td>stéganographie BPC <br>(paramètres <tt>0,10,20,30,999,999,999,999</tt>)</td> |

|||

</tr> |

|||

</table> |

|||

Si vous regardez attentivement, les pixels du ciel ou de la surface de l'eau sont nettement plus modifiés dans l'image centrale que dans l'image de droite. |

|||

Les arbres abstraits de syntaxe contiennent le minimum de sens de la chaine d'entrée, soit dans la plupart des languages de programmation les opérateurs, les opérandes et les structures de donnée. |

|||

'''Objectifs :''' |

|||

Dans l'exemple d'un bout de code HTML <nowiki>"<h1>Titre</h1>"</nowiki> nous voudrions obtenir un arbre nous indiquant seulement la présence de la balise <nowiki>"<h1>"</nowiki> contenant le mot "Titre" : |

|||

# implémenter (par exemple en Python) la stéganographie par bits de poids faible sur des images, |

|||

# comprendre et implémenter la stéganographie par plans de complexité, |

|||

# comparer les 2 approches sur des exemples |

|||

# si le temps le permet, regarder les technique de "stéganalyse" qui permettent de détecter la présence d'informations dissimulées dans une image. |

|||

[[Fichier:AST-h1.png|200px]] |

|||

'''Référence :''' |

|||

Pour obtenir cette arbre il faut transformer l'arbre de dérivation en sortie de l'analyseur syntaxique avec des attributs de productions. |

|||

# [https://web.archive.org/web/20120905034757/http://www.eece.maine.edu/~eason/steg/SPIE98.pdf Principle and applications of BPCS-Steganography] |

|||

# [https://web.archive.org/web/20110815205714/http://etd.lib.ttu.edu/theses/available/etd-06272008-31295018922590/unrestricted/31295018922590.pdf High capacity data hiding system using BPCS steganography] |

|||

=== [["tableau des suffixes" et transformée de Burrows-Wheeler]] === |

|||

==== Les arbres de dérivation ==== |

|||

Les arbres de dérivation notent toutes les dérivations ou réductions de productions au cours de l'analyse. Lors de la dérivation d'une production <math>N \rightarrow \alpha \beta</math> nous produirons un sous arbre avec en racine le non-terminal <math>N</math> et en nœuds enfants les symboles <math>\alpha</math> et <math>\beta</math> : |

|||

'''Tuteur :''' Sébastien Tavenas |

|||

[[Fichier:AST.png|200px]] |

|||

'''Résumé :''' Le [https://fr.wikipedia.org/wiki/Tableau_des_suffixes tableau des suffixes] est une structure de données qui permet de répondre très rapidement à des requêtes du style "est-ce que la chaine ''p'' apparait dans la chaine ''S'' ?" La chaine ''p'' pourrait être une "petite" chaine de quelques milliers de caractères, alors que la chaine ''S'' pourrait être une "grosse" chaine de plusieurs milliard de caractères. Les biologistes utilisent des requêtes de ce genre lorsqu'ils recherchent des motifs ''p'' dans l'ADN ''S''. Lorsque ''S'' ne change pas, l'arbre des suffixes permet de répondre à la requête précédente avec un nombre d'opérations beaucoup plus faible que la recherche naïve qui devrait regarder tous les caractères de ''S'' ! |

|||

Malheureusement la majorité des grammaires utilisées par les analyseurs descendant produisent des arbres de dérivation éloigné des arbres abstraits de syntaxe, comme la grammaire suivante : |

|||

Cette structure de données est également reliée à la transformée de Burrows-Wheeler, à la base de l'algorithme de compression <tt>bzip</tt>. |

|||

<ul> |

|||

<li><math> E \rightarrow id\ E'</math></li> |

|||

<li><math> E' \rightarrow op\ id\ E'</math></li> |

|||

<li><math> E' \rightarrow \epsilon </math></li> |

|||

</ul> |

|||

Cette grammaire optimisée pour l'analyse descendante par la suppression de l'ambiguité et l'utilisation de préfixes unique, produit pour le mot d'entrée "5 + 2 - 3" l'arbre de dérivation : |

|||

'''Objectifs :''' |

|||

[[Fichier:AST-expr.png|400px]] |

|||

# Le calcul naïf du tableau des suffixes se fait en quelques lignes de Python. Le premier objectif sera d'utiliser cette version pour expérimenter avec les algorithmes de recherche simples sur le tableaux des suffixes, et de comparer les temps d'exécution avec ceux des algorithmes standard. |

|||

# Transformer un tableau de suffixes en transformée de Burrows-Wheeler est également l'affaire de quelques lignes de Python. Le second objectif sera donc de coder les quelques fonctionnalités manquantes pour compresser, et décompresser des chaines de caractères ; et de comparer ceci avec d'autres algorithmes existants. |

|||

# le tableau des suffixes est plus petit que l'arbre des suffixes (variante un peu plus rapide, mais plus complexe), et la transformée de Burrows-Wheeler est encore plus petite. L'idée serait de comprendre d'où viennent ces différences et comment passer d'une structure à l'autre, et comment les améliorer. |

|||

# ... |

|||

'''Référence :''' |

|||

==== Les grammaires attribuées ==== |

|||

# les liens wikipédia (plutôt en anglais) cités ci dessus sont un bon début |

|||

# [https://www.cs.jhu.edu/~langmea/resources/bwt_fm.pdf Introduction to the Burrows-Wheeler Transform and FM Index] |

|||

# les [https://www.youtube.com/playlist?list=PL2mpR0RYFQsDFNyRsTNcWkFTHTkxWREeb vidéos de Ben Langmead] sur le sujet |

|||

# Dan Gusfield, ''Algorithms on Strings, Trees and Sequences'' |

|||

===[[le problème du collectionneur]]=== |

|||

Les transformations entre arbre de dérivation et arbre abstrait de syntaxe sont décrites par des règles attribués à chacune des productions. Ses règles permettent de lire ou écrire des attributs de symbole. |

|||

Pour éviter toute ambiguité entre les symboles dans les productions, les symboles de même nom sont renommés en <math>N_i</math>, <math> E' \rightarrow op\ id\ E'</math> devient <math> E_1' \rightarrow op\ id\ E_2'</math>. |

|||

'''Tutrice :''' Céline Labart |

|||

Les règles se regroupent en deux catégories, les règles synthétisées et les règles héritées. |

|||

'''Résumé :''' un collectionneur cherche à avoir toutes les vignettes d’une série |

|||

Les règles synthétisées modifient le non-terminal à gauche d'une production en fonction des attributs des symboles à droite de la production. |

|||

représentant des joueurs de foot. Chaque vignette représente un joueur, |

|||

En gardant le même exemple de grammaire, la production <math>E' \rightarrow \epsilon </math> doit produire un noeud vide, elle est associée à <math>E'.noeud = noeud()</math>. De même la production <math> E_1' \rightarrow op\ id\ E_2'</math> définit le noeud <math>E_1'</math> avec l'operateur : <math>E'_1.noeud = noeud(op.val)</math>. |

|||

il y a en tout ''N'' joueurs. Pour avoir une vignette, on doit acheter un |

|||

paquet de céréales. Chaque paquet de céréales contient une vignette |

|||

choisie de manière uniforme et indépendante au hasard parmi ces ''N'' |

|||

possibilités. Combien faudra t il en moyenne acheter de paquets de |

|||

céréales afin d'obtenir toute la série des ''N'' joueurs de foot? |

|||

'''Objectif :''' |

|||

Les règles héritées modifient des symboles à droite de la production en fonction des autres symboles à droite, les nœuds voisins, ou le non-terminal à gauche de la production. |

|||

# Ecrire un programme qui simule l'expérience |

|||

Ainsi la production <math> E_1' \rightarrow op\ id\ E_2'</math> doit basculer la valeur <math>id</math> dans le nœeud <math>E_2'</math>, elle est donc associée à la règle <math>E'_2.noeud.ajouter(noeud(id.val))</math>. |

|||

# en déduire une approximation le nombre moyen de paquets de céréales à acheter |

|||

# Résoudre le problème théoriquement |

|||

'''Références :''' |

|||

La totalité des règles est : |

|||

https://fr.wikipedia.org/wiki/Probl%C3%A8me_du_collectionneur_de_vignettes |

|||

<ul> |

|||

<li> <math> E \rightarrow id\ E' \Longrightarrow E.noeud = E'.noeud </math> </li> |

|||

<li> <math> E'_1 \rightarrow op\ id\ E'_2 \Longrightarrow E'_1.noeud = noeud(op.val) E'_1.noeud.ajouter(E'_2.noeud)</math> </li> |

|||

<li> <math> E' \rightarrow \epsilon \Longrightarrow E'.noeud = noeud() </math> </li> |

|||

<li> <math> E \rightarrow id\ E' \Longrightarrow E'.noeud.ajouter(noeud(id.val)) </math> </li> |

|||

<li> <math> E'_1 \rightarrow op\ id\ E'_2 \Longrightarrow E'_2.noeud.ajouter(noeud(id.val)) </math> </li> |

|||

</ul> |

|||

=== [[Jeu de la vie]] === |

|||

Dans notre cas les attributs <math>N.noeud</math> contiennent les nœuds de l'arbre abstrait de syntaxe et donc <math>E.noeud</math> est l'arbre abstrait de syntaxe entier. Un problème se pose toujours lors de l'ordre d'application des règles. En effet la règle <math>E \rightarrow id\ E' \Longrightarrow E'.noeud.ajouter(noeud(id.val))</math> nécessite que <math>E'</math> contienne déjà un attribut <math>noeud</math> valide. |

|||

Pour résoudre ce problème, il est possible de préfixer l'ordre d'exécution des règles manuellement lors de leur conception ou déterminer par une analyse l'ordre d'exécution par la construction d'un arbre de dépendance entre les règles. Dans ce cas, les règles n'ayant aucune dépendance sont exécuté puis les autres. |

|||

'''Tuteur :''' Romain Negro |

|||

== Le programme exemple == |

|||

'''Résumé :''' Le [https://fr.wikipedia.org/wiki/Jeu_de_la_vie jeu de la vie] est un [https://fr.wikipedia.org/wiki/Automate_cellulaire automate cellulaire] inventé dans les années 70 par John Conway dont les |

|||

Pour mettre en application les algorithmes d'analyse syntaxique, un programme à été écrit avec le support de l'analyse descendante et ascendante simple. |

|||

règles sont simples, mais dont des comportements macroscopiques complexes peuvent apparaître. Des simples structures immobiles aux structures semblant dotées d'intelligence, le jeu de la vie est |

|||

Ce programme est disponible dans le dépôt : https://github.com/panzergame/analyseur_cmi |

|||

[https://fr.wikipedia.org/wiki/Turing-complet Turing-complet]. |

|||

Le jeu de la vie se présente ainsi : sur une grille infinie, il y a des cellules vivantes ou mortes. A chaque étape, chaque cellule naît, reste en vie ou meurt en fonction de son 8-voisinage. Une cellule naît si |

|||

Un fois compilé, l'exécutable build/analyzer prend quatre arguments : |

|||

exactement 3 de ses voisins sont vivants. Une cellule reste en vie son état si celle-ci a entre 2 et 3 voisins vivants. Dans les autres cas, la cellule meurt. |

|||

Afin de faire fonctionner cet automate, l'approche naïve consiste à chaque étape à calculer pour chaque cellule son état suivant. Cependant, celle-ci ne fonctionne que sur une grille finie et n'est pas très |

|||

<ul> |

|||

efficace pour de plus grandes grilles. |

|||

<li>input_file : Fichier texte à analyser.</li> |

|||

<li>bnf_file : Fichier de description des productions.</li> |

|||

<li>regex_file : Fichier de description des règles lexicales et des séparateurs.</li> |

|||

<li>method : La méthode d'analyse, naive pour LL récursif, stack pour LL avec pile et slr pour SLR.</li> |

|||

<li>Résultat : un historique de l'analyse en console et un arbre de dérivation au format .dot : derivation_tree.dot.</li> |

|||

</ul> |

|||

Certaines approches permettent de travailler sur des grilles de taille infinie (en théorie), voire de pouvoir rapidement se déplacer de plusieurs étapes dans le temps. D'autres approches permettent même de |

|||

Les fichiers de description de règles bnf_file et regex_file utilise le format Backus Naur Form, encadrant chaque non-terminal par "<>" et associant des productions à des non-terminaux grâce à "::=", ainsi <math>N \rightarrow ab</math> s'écrit : |

|||

s'affranchir de la notion de grille et d'étapes. |

|||

<pre> |

|||

<N> ::= a b |

|||

</pre> |

|||

'''Objectifs :''' |

|||

Pour analyser les expressions simple de la forme "a + b", il faut tout d'abord définir les règles de l'analyseur lexical ainsi que les séparateurs additionnels : |

|||

# implémenter (en Python ou Javascript) une version naïve du jeu de la vie sur une grille finie, |

|||

# proposer une implémentation permettant d'effectuer la simulation sur une grille infinie, |

|||

# comprendre et si le temps le permet implémenter la simulation en utilisant une approche en arbre. |

|||

# s'il reste encore du temps, comprendre comment fonctionne l'approche continue du jeu de la vie |

|||

'''Référence :''' |

|||

<pre> |

|||

# Liens wikipédia cités dans le résumé |

|||

<separator> ::= +-/* |

|||

# [https://johnhw.github.io/hashlife/index.md.html Implémentation utilisant des arbres] |

|||

# [https://arxiv.org/pdf/2005.03742 Lenia : jeu de la vie "continu"] |

|||

<integer> ::= [0-9]* |

|||

<float> ::= [0-9]*\.[0-9]*f? |

|||

<identifier> ::= [A-z]([A-z]|[0-9])* |

|||

<operator> ::= \+|\-|/|\* |

|||

===[[Modèle proie-prédateur sans équations]]=== |

|||

</pre> |

|||

'''Tuteur :''' Mouloud Kessar |

|||

Ici quatre unités lexicales sont définit pour reconnaitre les entiers (integer), les flottants (float), les noms (identifier) et les opérateurs (operator). De plus les opérateurs sont aussi utilisés pour séparer la chaîne d'entrée. |

|||

'''Résumé :''' |

|||

Ensuite pour un analyseur ascendant les règles seront au format BNF : |

|||

les équations de prédation de Lotka-Volterra sont relativement simples sur le plan mathématiques et permettent d'étudier l'évolution d'une population de proies (typiquement des lapins) et de prédateurs (typiquement des renards). Avec le bon jeu de paramètres, on peut observer des cycles dans le nombre de proies et de prédateurs. L'objectif de ce projet est d'observer de tels cycles sans utiliser d'équations, mais des déplacements aléatoires sur une grille à deux dimensions. |

|||

Les règles de base sont les suivantes: |

|||

<pre> |

|||

*A chaque itération, chaque individu se déplace d'une case dans une direction aléatoire(haut/bas/droite/gauche). |

|||

<value> ::= identifier | float | integer |

|||

*Les proies sont mangées par les prédateurs lorsqu'elles se retrouvent au même endroit que l'un d'eux. |

|||

<expr> ::= <value> operator <expr> | <value> |

|||

*Les proies(respectivement prédateurs) voient leur population doubler toute les <tt>nr_proie</tt> (resp. <tt>nr_pred</tt>) itérations. |

|||

<root> ::= <expr> |

|||

*On suppose que les proies ont toujours à manger. |

|||

</pre> |

|||

*Si un prédateur n'a pas mangé pendant <tt>n_faim</tt> itérations, il meurt. |

|||

L'objectif du projet est le suivant: |

|||

Ici nous validons les mots composés de valeurs entremêler d'opérateurs, où les valeurs peuvent être des noms, entiers ou flottants. Le nom-terminal <pre><root></pre> et le nom prédéfinit pour l'axiome de la grammaire. |

|||

#Ecrire un programme en python qui suit les règles de base. |

|||

Pour le fichier input_file contenant "5 + 4.2 - 80", l'exécution de la commande avec le méthode slr produit en console un récapitulatif des règles présentes puis un historique de l'analyse et un affichage de l'arbre de dérivation qui se retrouve aussi dans derivation_tree.dot : |

|||

#Visualiser l'évolution du nombre de proies et de prédateurs en fonction du temps, pour différentes valeurs de <tt>nr_proie</tt>, <tt>nr_pred</tt>, <tt>n_faim</tt> |

|||

''Remarque :'' Des précisions supplémentaires seront discutées avec le tuteur au faire et à mesure de l'avancement du projet pour concrétiser l'implémentation des règles de base. |

|||

[[Fichier:Analyseur-resultat.png|400px]] |

|||

'''références:''' |

|||

#[https://fr.wikipedia.org/wiki/%C3%89quations_de_pr%C3%A9dation_de_Lotka-Volterra Les équations de prédation de Lotka-Volterra] |

|||

#Exemple de déplacement aléatoire: [https://fr.wikipedia.org/wiki/Mouvement_brownien Le Mouvement Brownien] |

|||

===[[Où placer une (ou plusieurs) antennes 5G dans un village ?]]=== |

|||

'''Tuteur :''' Dorin Bucur |

|||

'''Résumé :''' Cette question, présentée ici de manière simplifiée, est très importante et |

|||

apparaît sous différentes formes dans la planification économique. Sa |

|||

modélisation repose sur des notions mathématiques relativement simples, et sa |

|||

résolution implique généralement l'utilisation d'algorithmes numériques |

|||

d'optimisation. De manière simple, on devra chercher à positionner un certain |

|||

nombre de points dans un ensemble donné du plan, de telle manière à ce que la |

|||

moyenne de la distance à l'ensemble des points soit minimale. |

|||

En s’appuyant sur les deux références fournies, l’étudiant devra : |

|||

*Ecrire un modèle mathématique associé à ce problème |

|||

*Comprendre le rôle des diagrammes de Voronoï |

|||

*Effectuer une analyse élémentaire de quelques cas simples (par exemple : une antenne dans un village circulaire, deux antennes dans le même village, etc.) |

|||

*Proposer une méthode de résolution numérique en développant un algorithme d'optimisation de type gradient, implémenté en Python. |

|||

'''Références:''' |

|||

#https://www.palais-decouverte.fr/fileadmin/fileadmin_Palais/fichiersContribs/au-programme/expos-permanentes/mathematiques/Bloc_Formes/pdf_revue/359_nov_dec_2k8.pdf |

|||

#https://doi.org/10.1080/00029890.2002.11919849 |

|||

===[[Introduction à la complexité et sa formalisation]]=== |

|||

'''Tuteur :''' Tom Hirschowitz |

|||

'''Résumé :''' La notion de complexité d'un programme est une abstraction du temps que va mettre le programme pour calculer son résultat. Plus qu'une durée concrète, mesurée en secondes, il s'agit avant tout de prédire le comportement du programme sur des paramètres de plus en plus grands. Des travaux assez récents développent des langages où la complexité peut être contrôlée directement. L'objectif serait de découvrir sur des exemples simples la notion de complexité, et de regarder comment fonctionnent ces langages qui permettent de l'internaliser. |

|||

Ces langages utilisent un style de programmation assez différent des langages utilisé en L1 (comme Python) : ce sont des langages dits ''fonctionnels''. La première partie du projet sera donc la découverte d'un langage fonctionnel, [https://ocaml.org/ OCaml]. La seconde partie consistera à explorer le langage expérimental [https://github.com/jonsterling/agda-calf calf], le ''cost-aware logical framework''. |

|||

== Sujets proposés 2023-2024 == |

|||

=== [[Calcul approché de l'élément majoritaire, et autres algorithmes approchés]] === |

|||

'''Tuteur :''' Pierre Hyvernat |

|||

'''Résumé :''' en informatique, il est parfois préférable d'accepter un résultat "pas complètement correct", si cela permet d'être plus rapide. Un des premiers problèmes de ce genre est le problème du voyageur de commerce : aucune méthode efficace pour calculer le meilleur trajet n'est connue, mais sous certaines conditions, il existe une méthode efficace qui donne un résultat "pas trop éloigné de l'optimum". |

|||