Complexité pratique contre complexité théorique

Principe de la complexité

La complexité en algorithmique sert à montrer l'efficacité d'un algorithme, en fonction de plusieurs facteurs comme son temps d'exécution, l'espace qu'il occupe dans la mémoire... (ces facteurs sont en générale induits par le nombre d'opérations qu'effectue l'algorithme).

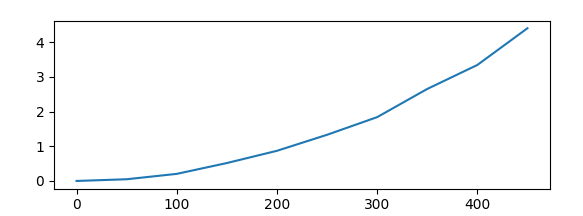

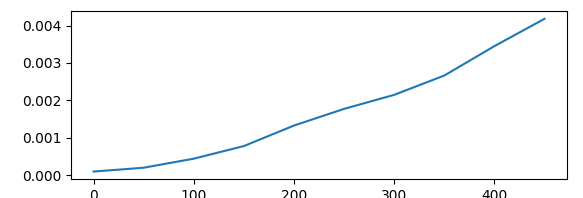

Afin de mesurer et de représenter cette complexité, on représente l'évolution du temps d'exécution d'une même fonction en fonction de la taille de ses argument.

On va donc, la plupart du temps utiliser des tableaux en entrée des fonctions, et faire évoluer leurs taille afin d'obtenir la courbe de leur complexité.

Cette courbe va ainsi nous éclairer sur le comportement asymptotique de l'algorithme. Ce comportement asymptotique représente le comportement général de la fonction de la complexité (souvent impossible à calculer de manière exacte).

Cette approximation est généralement représenté par , ou f(n) représente une fonction telle que pour n ->, (où c(x) représente la fonction de la complexité).

Ce comportement asymptotique peut être analysé sous deux différents point de vue:

Le point de vue théorique, qui va analyser le comportement générale de deux complexité et déduire la quelle des deux est la moins complexe en prenant la valeur vers laquelle tend O(f(n)) pour Échec de l’analyse (SVG (MathML peut être activé via une extension du navigateur) : réponse non valide(« Math extension cannot connect to Restbase. ») du serveur « https://wikimedia.org/api/rest_v1/ » :): {\displaystyle +\infty}

.

Le point de vue pratique, qui, quand à lui va analyser le comportement générale de deux complexité en fonction d'une taille de tableau limité par l'utilisation régulière de la fonction ou capacité a traiter les information de

l'ordinateur.

Etudes d'algorithmes

Afin de mesurer la complexité avec le langage python, on utilise généralement une fonction essentielle, la fonction "timeit"

import timeit

def chronoquick(tab,nessais):

'''Entrées: un tableau et un entier, Sortie: un entier'''

res = timeit.timeit("quickselectmed("+ str (tab)+")","from __main__ import quickselectmed" , number= nessais)

return res